Esxi 6 – Vcenter 6 – Storwize v3700 Yüksek Erişilebilirlik–High Availability Konfigüurasyonu – Networking ve LACP

Bu dokümanda Esxi 6.0 kümeleme (cluster) yapısı kullanılarak sanallaştırma altyapısı kurulum ve konfigurasyonları yer almaktadır.Konu başlıkları;

1) Esxi 6.0 kurulumu ve konfigurasyonu

2) Storwize v3700(storage) kurulumu ve konfigurasyonu

3) Vcenter 6.0 kurulumu ve konfigurasyonu

4) HA (High availability) konfigurasyonu

5) Networking ve Lacp konfigurasyonu

Anlatılacaktır.

ESXI 6.0 kurulumu ve konfigurasyonu

Vmware Esxi 6.0 kurulum medyasına https://my.vmware.com/web/vmware/details?productId=491&rPId=8761&downloadGroup=ESXI600 bu linkten register olduğunuz hesap ile giriş yapıp esxi ürünününe ulaşabilirsiniz.

ESXi ISO image (Includes VMware Tools)

File size: 348 MB

File type: iso

Iso dosyasını bir media ya basıp cd/dvd/pxe ve ya usb den boot edebilirsiniz.

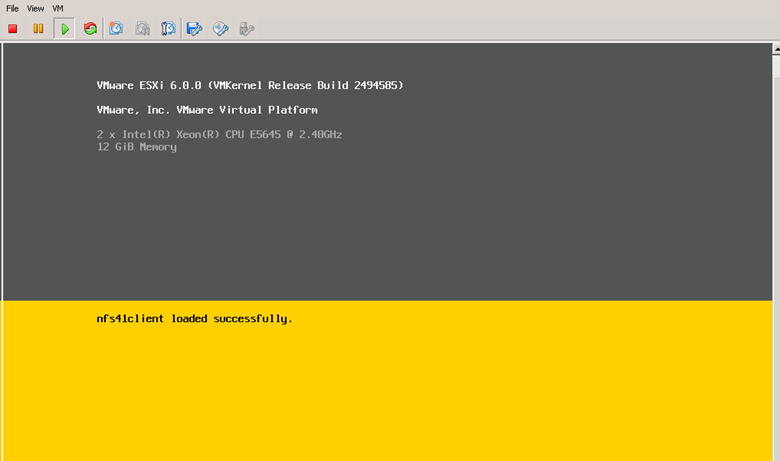

Sadece buradakı esxi 6.0 kurulumu temsili olarak type-1 hypervisor üzerinde gerçekleştirmiştir yani bir sanal platform üzerinde.Onun dışında tüm ürünler sıfırdan kurulum yapılarak anlatılacaktır(storwize,vcenter,networking) Nested esxi kurulumu yani sanallaştırılmış esxi olarak geçmektedir.Normal esxi ve nested esxi arasındaki kurulumda bir fark yoktur.Aradaki fark sadece platform farkıdır.Yani fiziksel cihaz yani bir sunucu üzerine kurulum ve ya type-1 hypervisor üzerine kurulum ( vmware workstation,oracle vm virtualbox,virtual pc gibi).

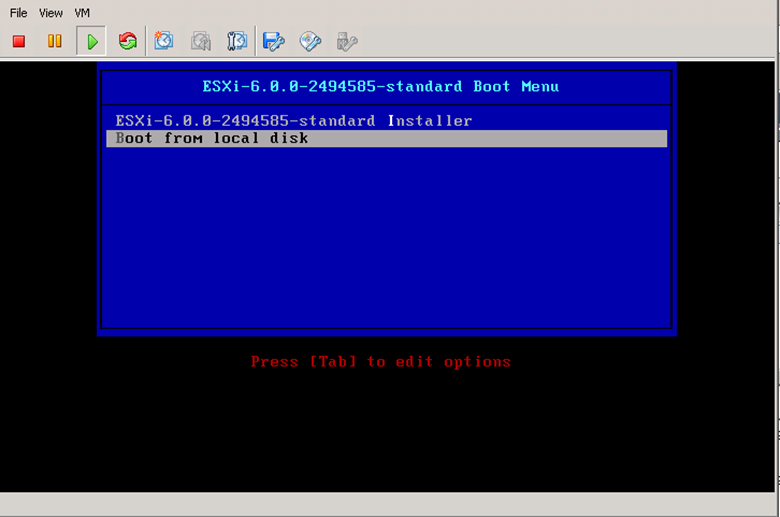

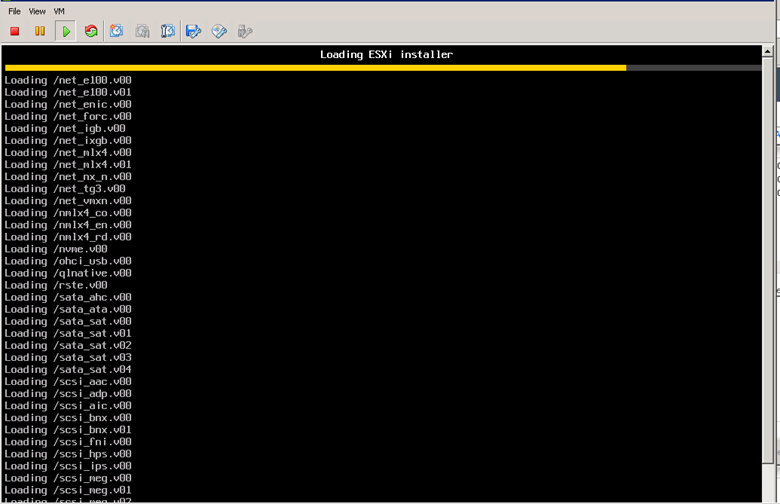

Hazırlamış olduğumuz kurulum medyasını sunucuya takıp boot işlemini gerçekleştiriyoruz.

Esxi 6.0.0-24994585-standard Installer I seçerek ilerleyin.

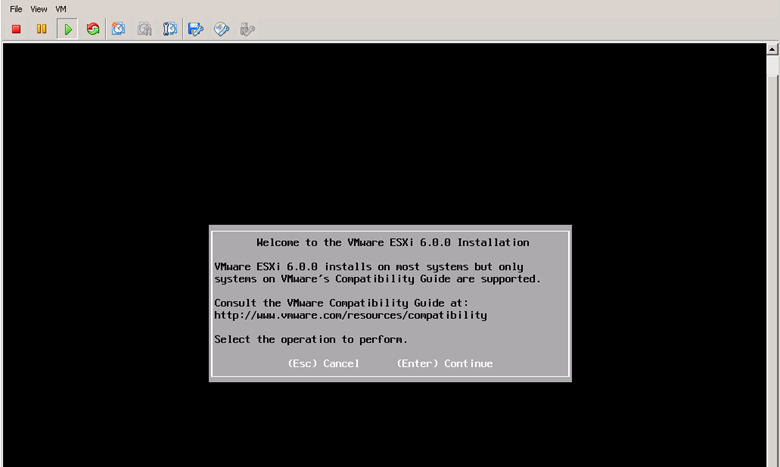

Enter diyerek devam edin.

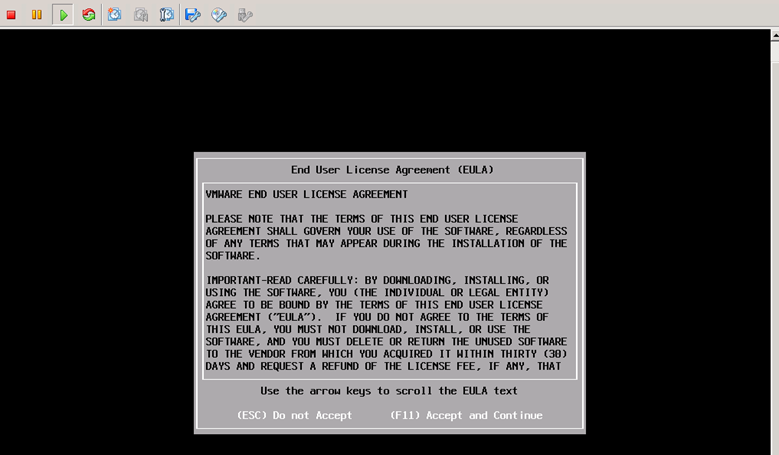

F11 ile lisans anlaşmasını kabul ediyoruz.

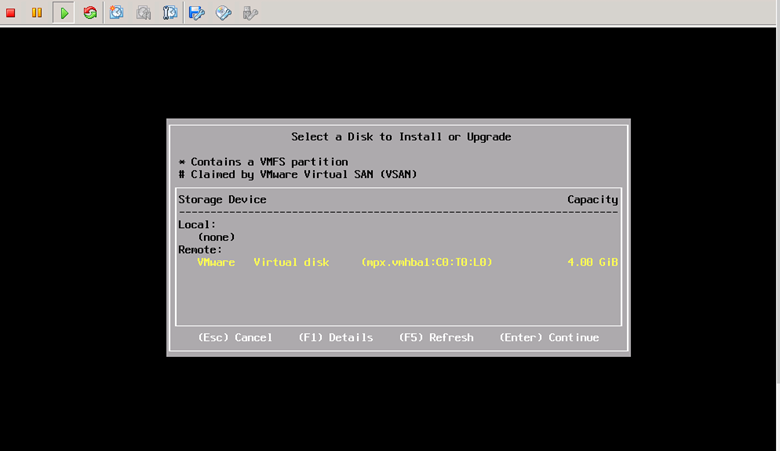

Burada kurulumu hangi diske yapmak istiyorsak o diski seçiyoruz.Sunucuda 4.00 gigabyte’lık alana kurulum yapacağım.Enter diyerek devam ediyoruz.

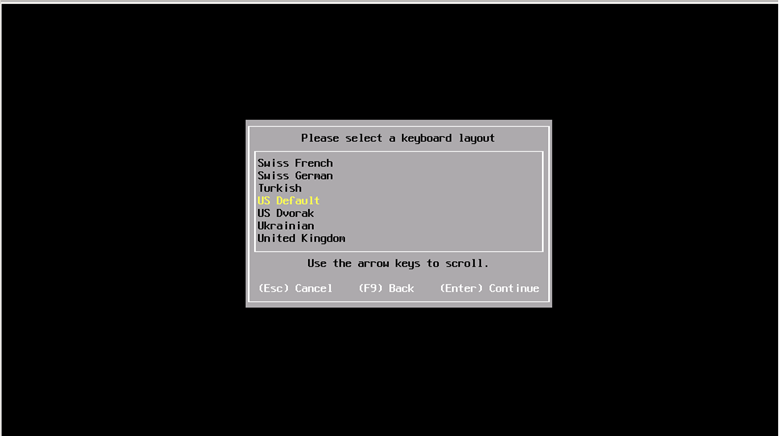

Klavye seçimini yapıyoruz.

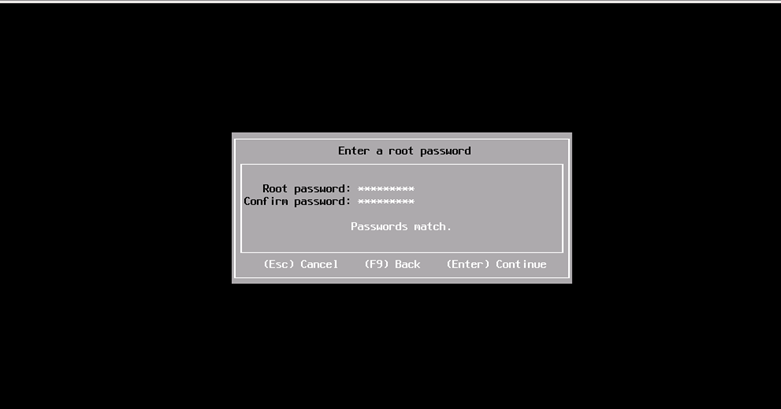

Esxi sunucusu için root şifresini tanımlaması tanımlıyoruz.

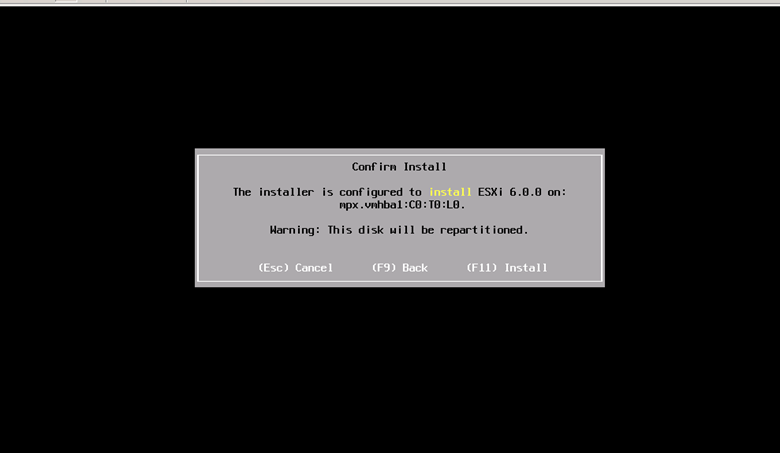

Disk üzerinde tüm datanın sileneceğine karşı bizi uyarıyor.Install diyerek devam ediyoruz.

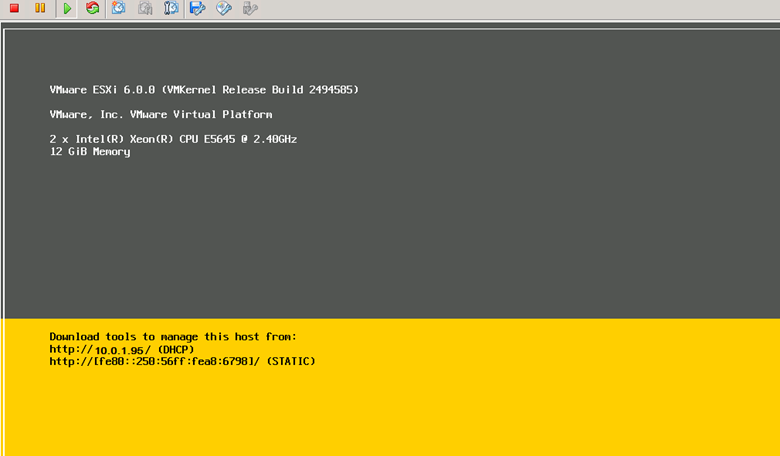

Kurulum sonrasında cihaz network’e bağlı ise dhcp den otomatik olarak ip alacaktır.Yoksa F2 ile configure management network diyerek static olarak ip tanımlamayabilirsiniz.

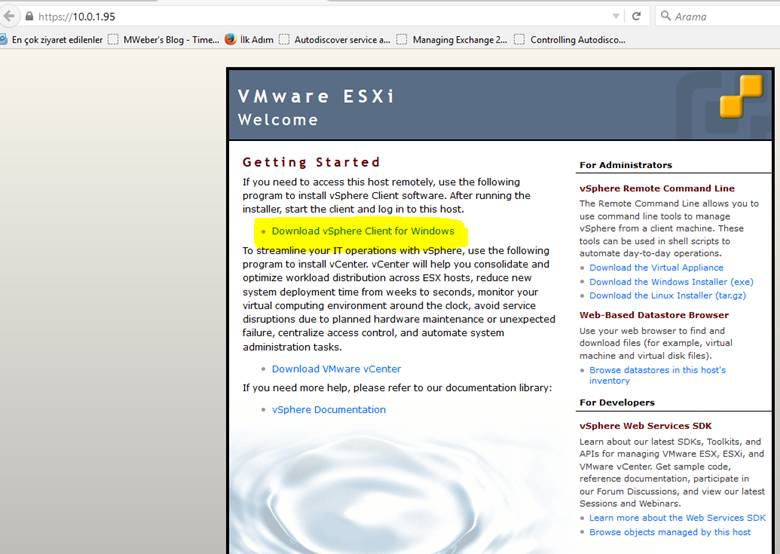

Daha sonra bir browser açıp adres satırına esxi ip adresini yazıp vsphere client’I indiriyoruz.

Kurulumu gerçekleştirdikten sonra vsphere client ile esxi sunucuya bağlanıyoruz.

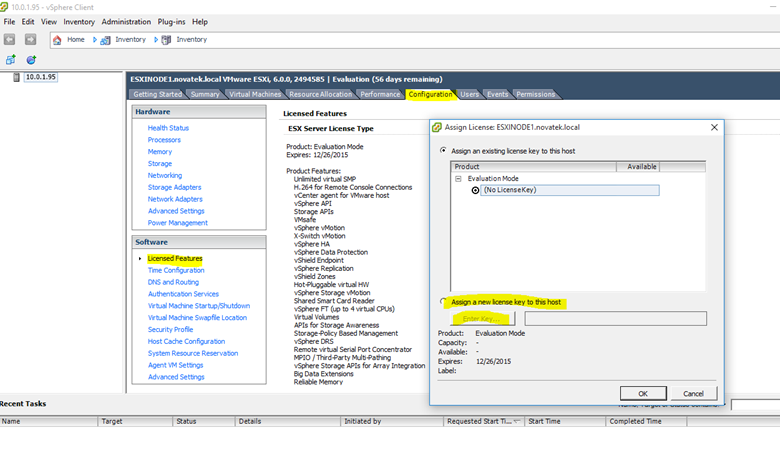

İlk önce lisans atamasını gerçekleştiriyoruz.

Lisans atamasını gerçekleştirdikten sonra dns konfigurasyonuna geliyoruz.

Burada kesinlikle hostname, dns tanımlarını giriyoruz.

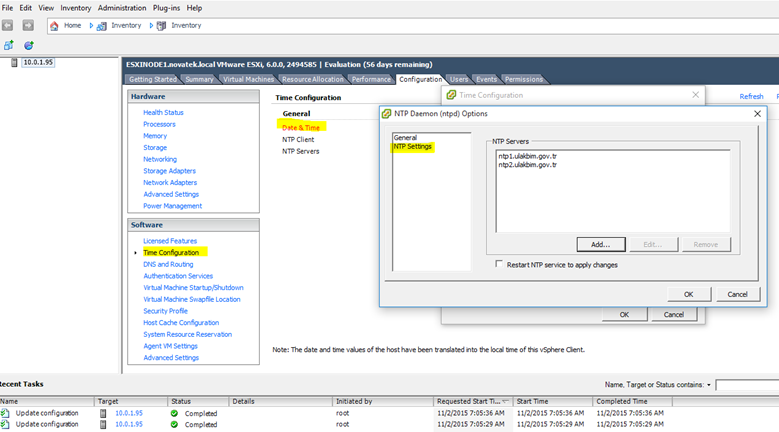

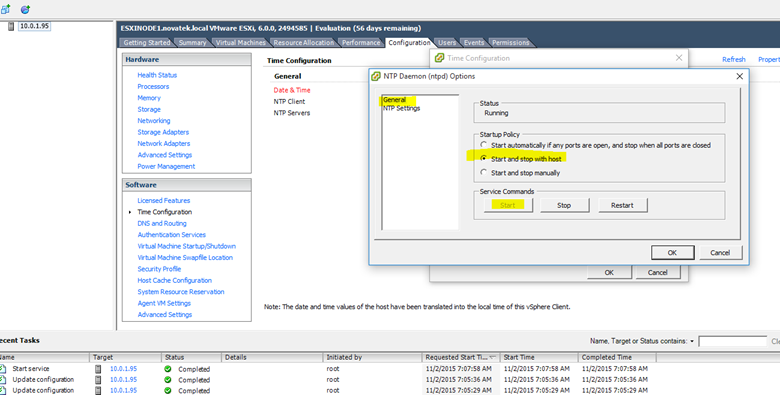

Time configuration bölümüne geliyoruz.

Ntp servisini isterseniz stop edebilir ve ya start edip ntp tanımını yapabilirsiniz.Eğer ki sanal sunucuların ntp bilgilerini kendi işletim sistemi üzerinden değilde esxi den almak istiyorsanız her sanal sunucya vmtool u yükleyip ntp client burada enable duruma getirmeniz gerekiyor.

Her iki esxi sunucuda aynı şekilde kurulumları gerçekleştiriyoruz.

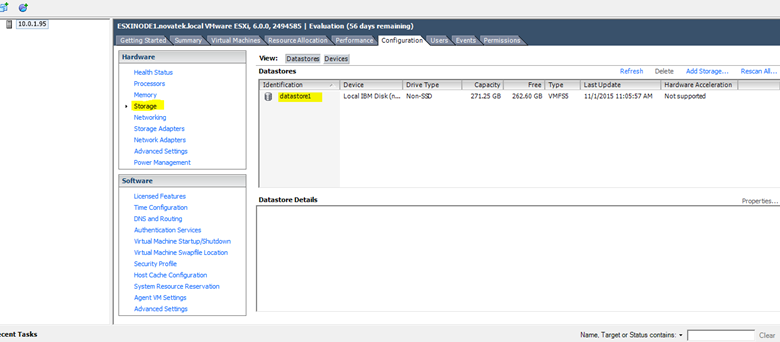

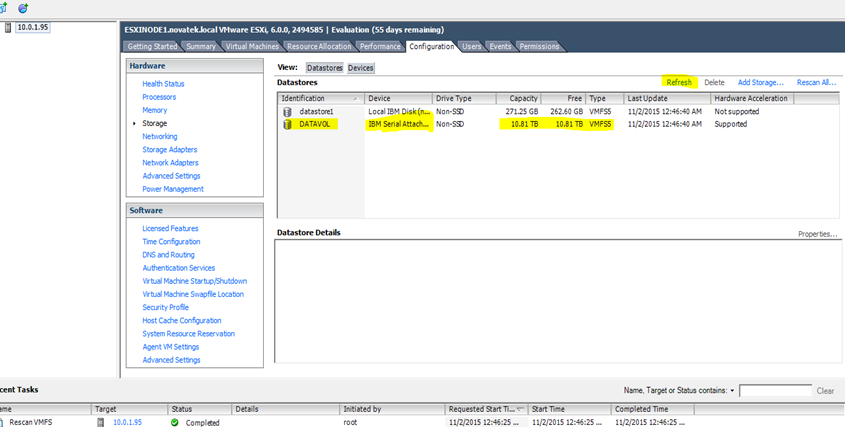

Görüldüğü gibi şuan da üzerinde local disk alanı mevcut.Cluster gereği storwize üzerinde ortak bir volume oluşturup iki sunucuyada map edeceğiz.

2) Storwize kurulumu ve konfigurasyonu

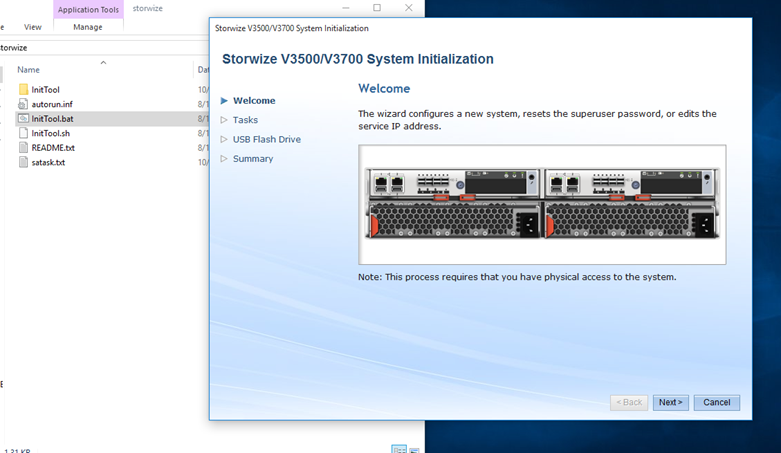

Storwize kurulumu için öncelikle storwize üzerinde A port una bir data kablosu takıp networkden erişebilir olduğuna emin bunun için zarfın içinde gelen usb tool ile storwize e ip adresi verip consola erişebilir hale getirmemiz gerekiyor.

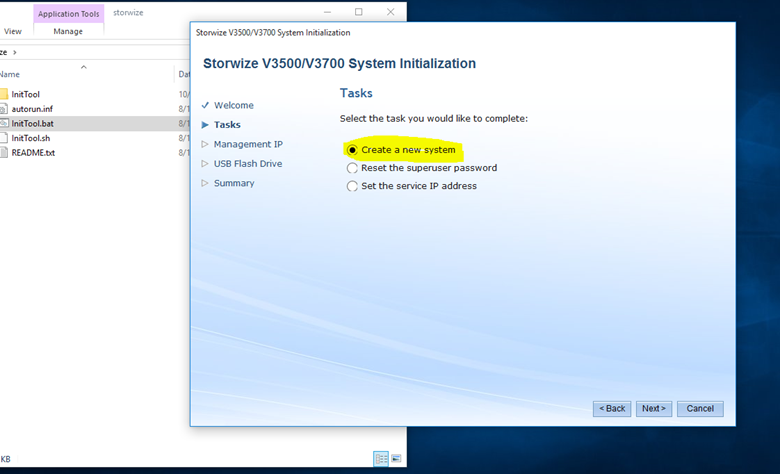

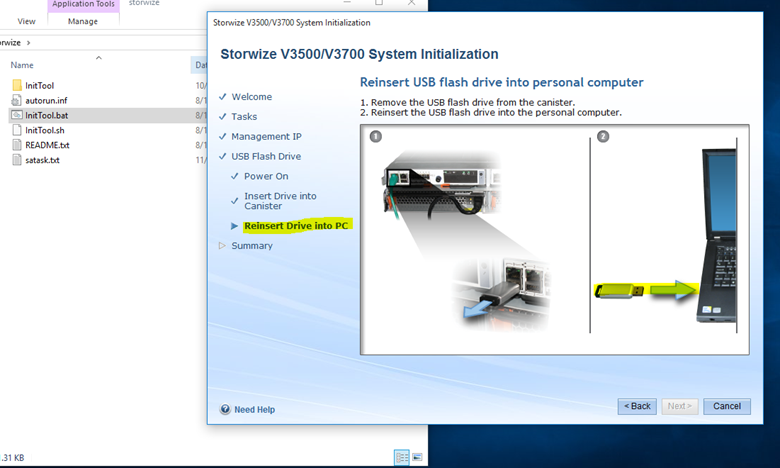

Usb yi bilgisayarınıza takıp içerisindeki inittool u çalıştırın.

Next diyerek devam edin, Create a new system I seçin.

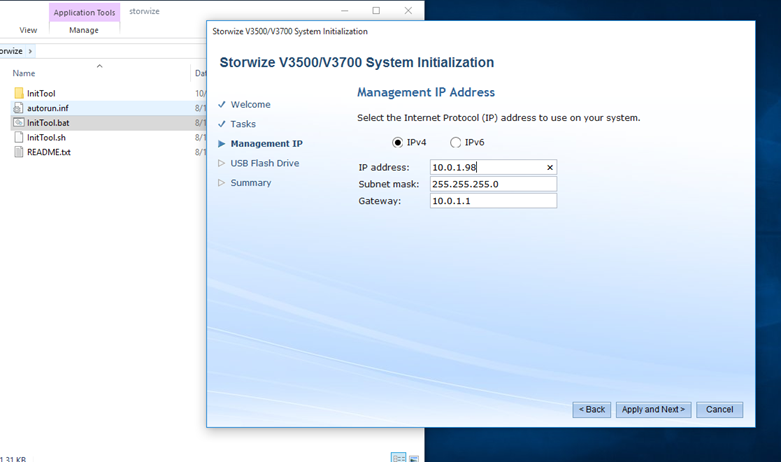

Storwize erişirken kullanacağınız ip adresini seçin.

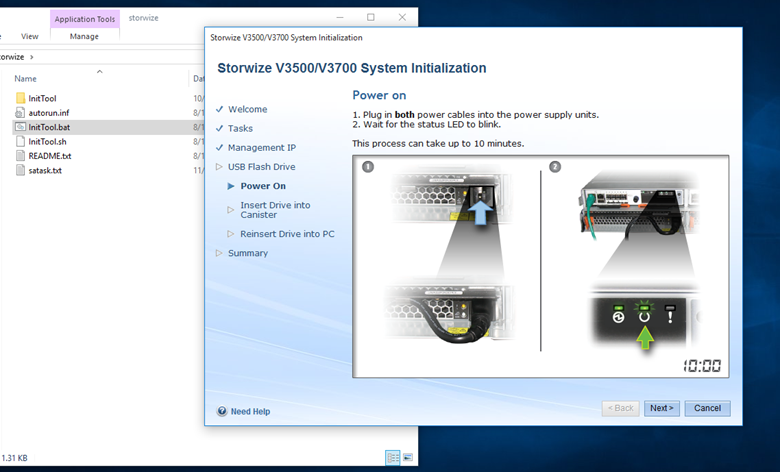

Storwize ‘in açık olduğuna ve her iki güç kablosununda bağlı olduğuna emin olun.

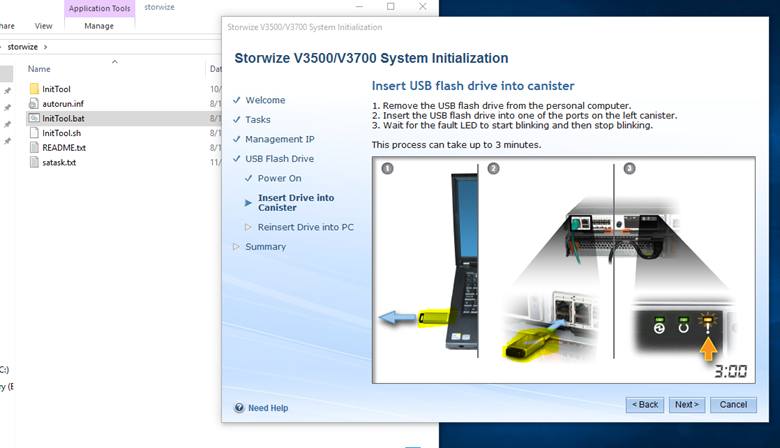

Flash diski çıkarıp Storwize üzerinde 1.ethernet portunun altındaki usb portlardan birine takın.Sağ tarafta uyarı ledi turuncu şekilde yaklaşık 3 dakika yanıp sönecektir.Usb flash disk içerisindeki tanımlamaları storwize a yazacaktır.Uyarı ledi yeşile döndükten sonra flash diski çıkarıp tekrar bilgisayarınıza takın.

Next diyerek devam edin, ve summary kısmında finish diyerek işlemi tamamlayın.

Storwize’de 1.ethernet portunu bir data kablosu ile network’e bağlayın.

Bir browser açıp storwize ip adresini yazarak konsola erişin.

Default username: superuser

Default password: passw0rd

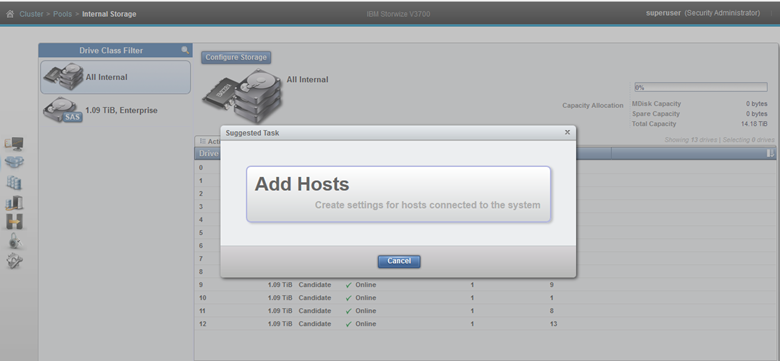

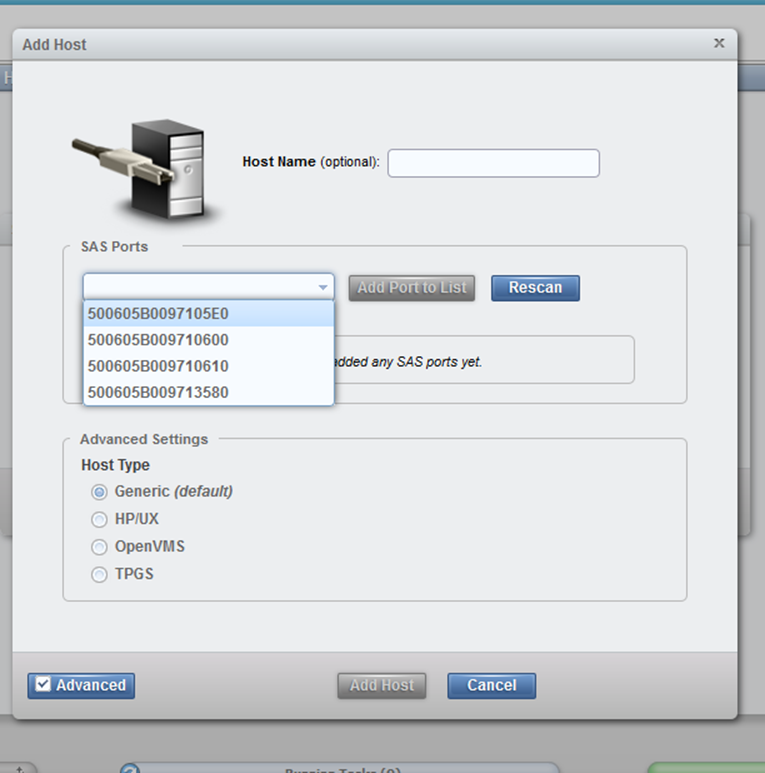

Giriş yaptığımızda bizden storwize erişecek fiziksel sunucularımızı eklememizi isteyecektir.Add hosts diyerek host mapping bölümüne geliyorum.

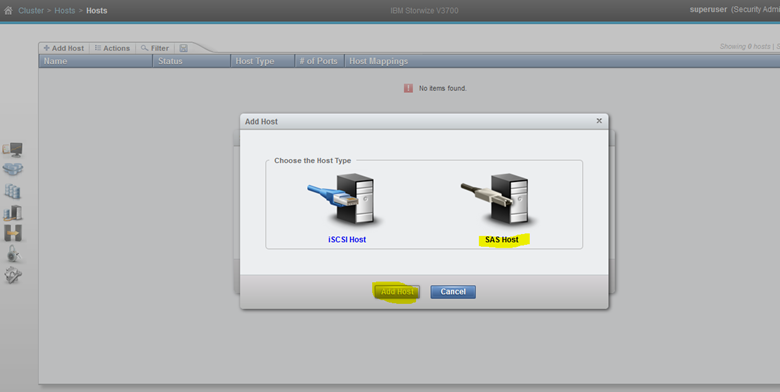

Sunucu üzerinde sas hba adaptor ler takılı olduğu için sas host bağlantı tipi geldi.Eğer fibre hba takılı olsayda oda burada görünecekti.

İki sunucu üzerindeki sas hba adresleri storwize üzerinde görünebilir hale geldi.Sas adreslerini düzgün şekilde görüntüleyebilmek için storwize ve sunucu arasındaki sas bağlantı şeklinin düzgün yapılması gerekiyor.

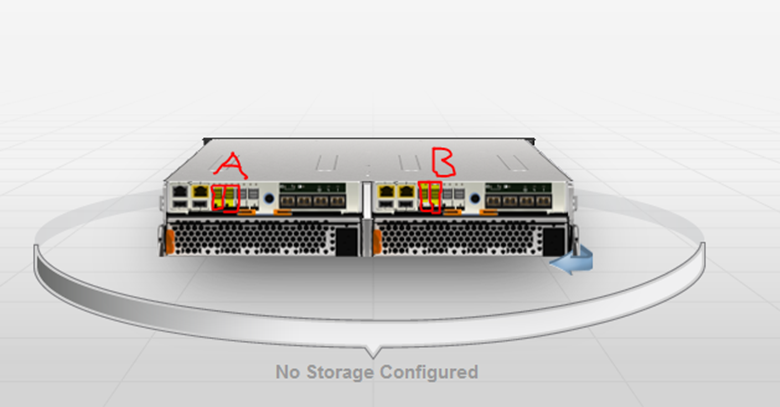

Bunun için storwize üzerinde iki controller üzerinden A ve B den çapraz şekilde sunuculara bağlanmanız gerekmektedir.

Storwize’da a ve b controller da 1.mini sas portları her iki sunucuda 1.sas portlara bağlayın.

Storwize’da a ve b controller da 2.mini sas portları her iki sunucuda 2.sas portlara bağlayın.

Storwizde 4.port expansion slot için gereklildir.Storwize a disk enclosure eklemek için kullanılır.

Eğer doğru şekilde bağladıysanız 4 adet sas adresini görebileceksiniz.

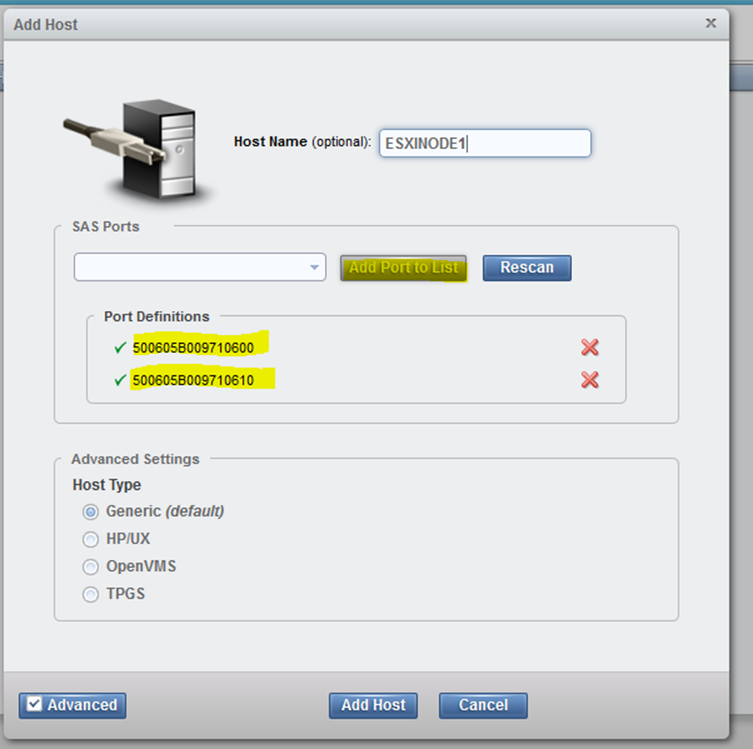

Sunuculara doğru şekilde volume I map edebilmek için portları sunucular için gruplandırıyorum.Böylece hangi host a hangi volume I eklemişiz görebileceğiz.

Sas adreslerini isterseniz kart üzerinden görebilir vey a plug and unplug yaparak test edebilirsiniz.

esxinode1

500605B009710600

500605B009710610

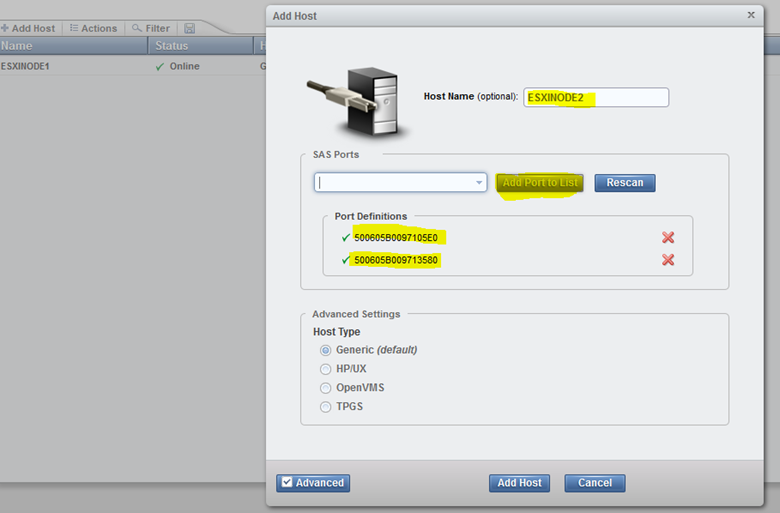

esxinode2

500605B009713580

500605B0097105E0

Sırası ile host’ları oluşturuyorum.

İkinci node’du tanımlıyorum.

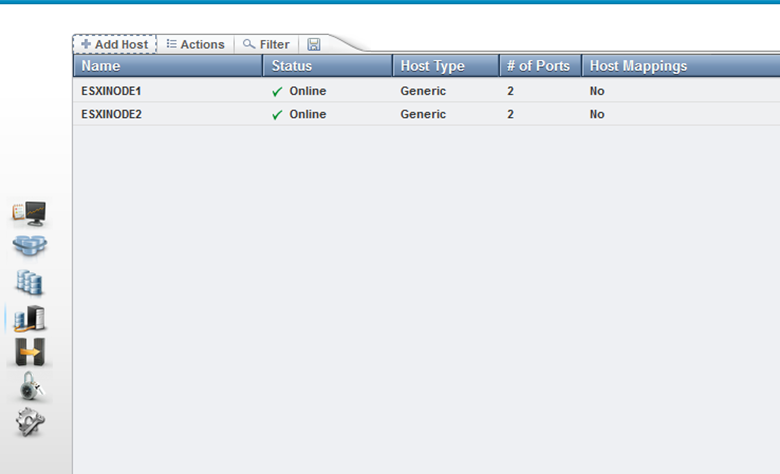

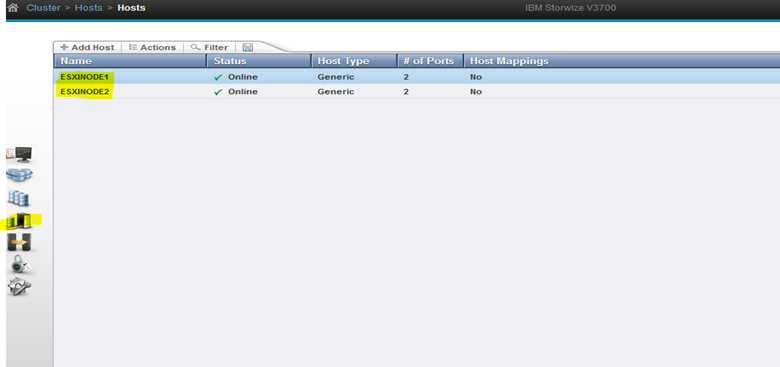

İki hostumuzda storwize’a tanımlanmış oldu , şimdi volume oluşturma işlemine geçeceğiz.

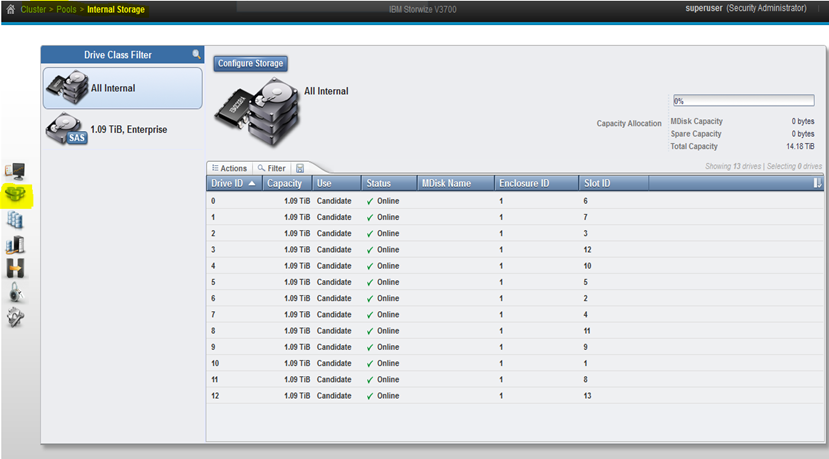

Pools bölümünden internal storage a geliyoruz.

Storwize ekli olan diskleri görüyoruz, buradaki disklerinin hepsinin “candidate”olarak göründüğünden ve online olduğundan emin olun.Volume oluşturabilmemiz için öncelikle bir disk havuzu oluşturup sonrasında volume oluşturma işlemine geçeçeğiz.

Yapımızda 13 adet 1,09 tib disklerimiz mevcut biz en az net kullanabilir 10 tb alan istiyoruz ve full tolerance ve maximum capacity istiyoruz.Bu yüzden 2 x raid 5 grubu ve +1 hot spare oluşturup raid bütünlüğünü olası bir fail durumuna karşı önlemiş olacağız.

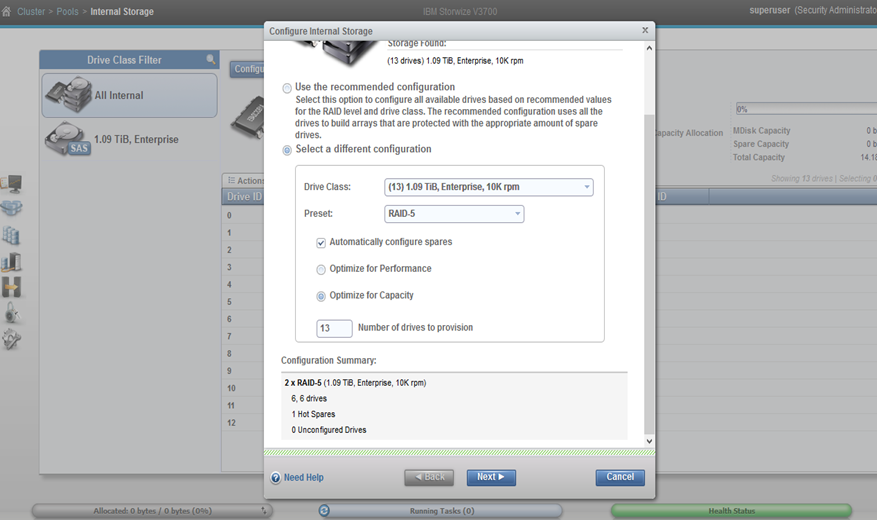

Configure storage diyerek pool oluşturma işlemine başlıyoruz.

Select different configuration I seçiyorum, preset olarak raid-5, hot spare ayırması için automatically configure spares I işaretliyorum.Next diyerek ilerliyorum.

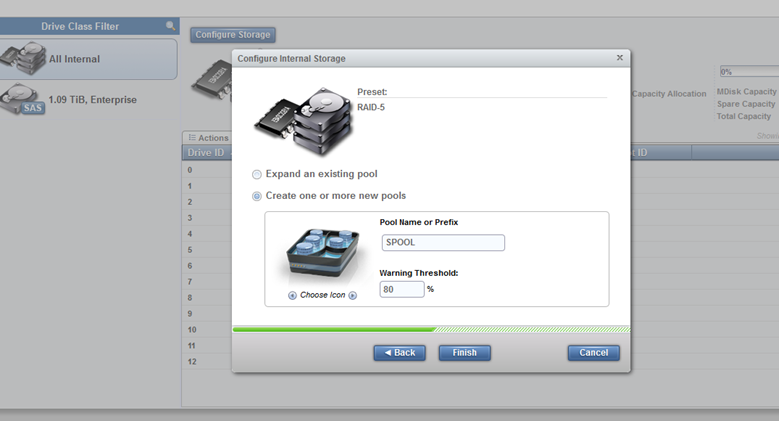

Sonraki aşamada benden bir havuz oluşturmamı istiyor, sas diskler için spool isimli kendinize göre belirleyebilirsiniz bir isim veriyorum, threshold değeri default olarak 80 dir, değiştirebilirsiniz.

Finish diyerek işlemi bitiyorum ve işlemimiz tamamlandı.

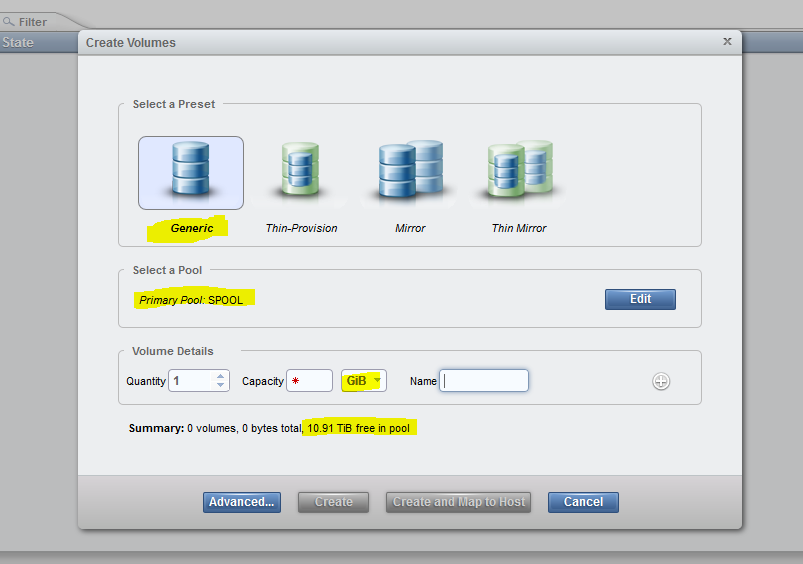

Sol tarafında volumes kısmında gelip create volumes diyerek volume oluşturma işlemine geçiyorum.

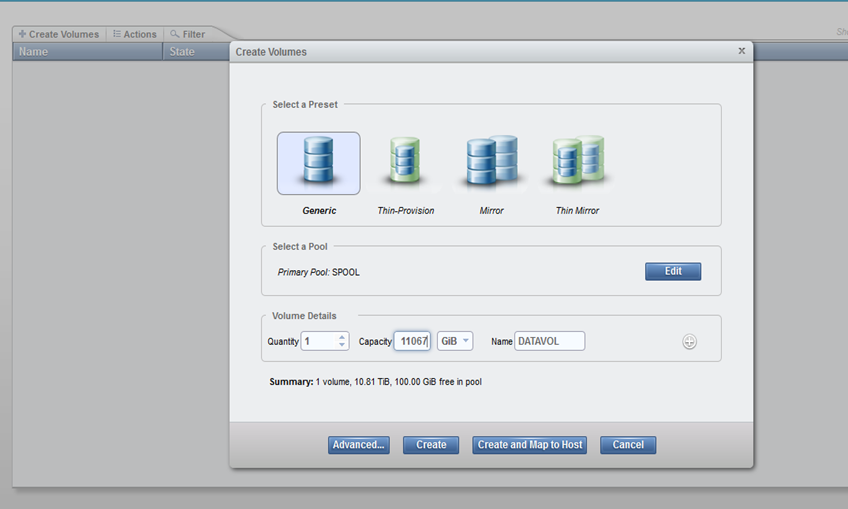

Preset olarak generic , pool olarak oluşturduğum spool havuzunu seçiyorum,bana aşağıda maksimum ne kadarlık bir alan oluşturabileceğimi söylüyor.Ben aşağıdaki alanine tamamını fakat storwize’inde operasyonel işlemlerini yapabilmesi için 100 gb bir alanı da storwize a bırakacağım , o yüzden 10.81 tb bir alanı “datavol” için ayıracağım.

Create diyerek volume’I oluşturuyorum.

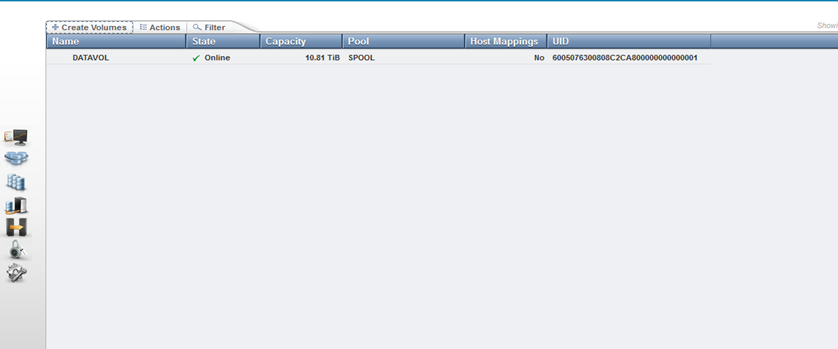

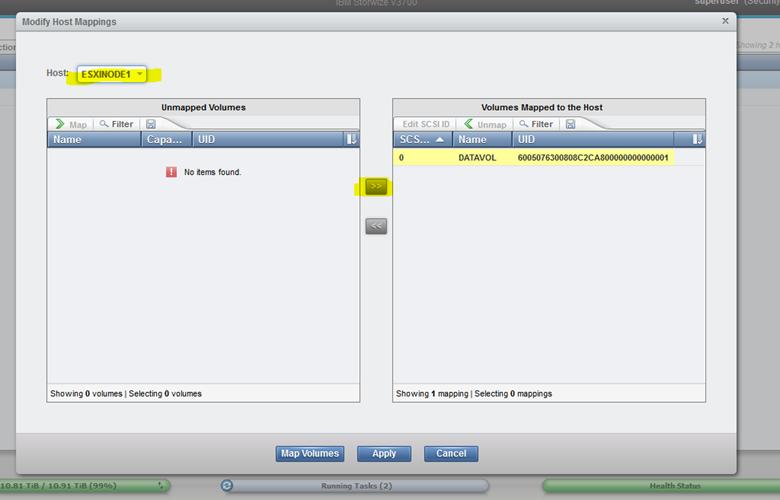

Datavol isimli volume oluştu, şimdi bi volume’ I esxi sunuculara map edeceğiz.

İsterseniz volume sağ tıklarak map to host diyebilirsiniz vey az önce oluşturmuş olduğumuz hostlara gelerek oradan da host mappings kısmına gelerek volume I sunuculara atayabilirsiniz.

Hosts kısmına gelip herhangi bir host a sağ tıklayıp modify mappings diyerek volume iki sunucuyada map ediyorum.

Sırasıyla “host”bölümünde hostları seçip volume seçip “ >> “ ile volume I sağ tarafa geçirip map volumes diyerek mapping işlemini tamamlamıyorum.

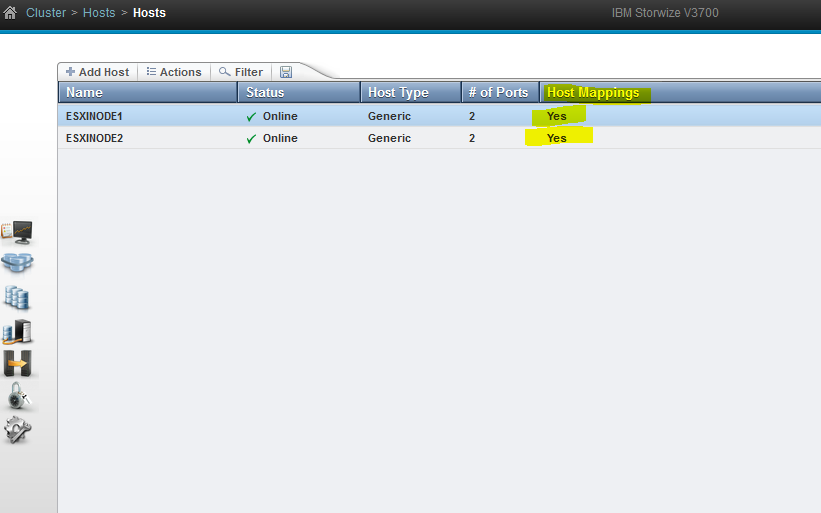

Iki tarafta da “Host Mappings” YES olarak görünüyor.Volume artık esxi sunuculara eklendi.Şimdi esxi sunucularda gerekli kontrolleri yapalım.

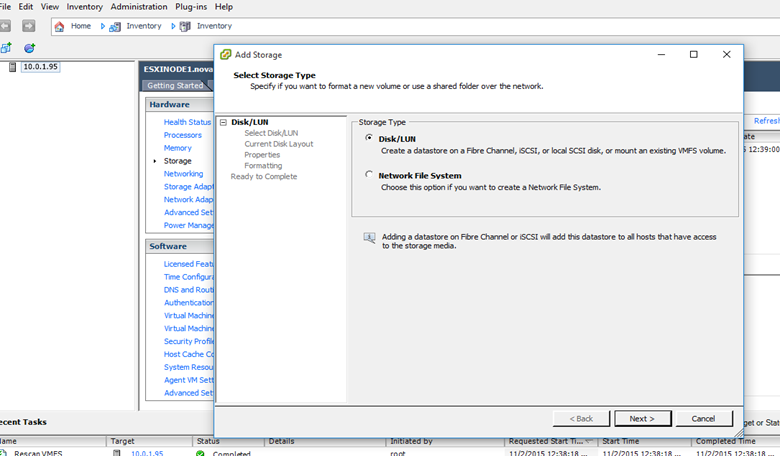

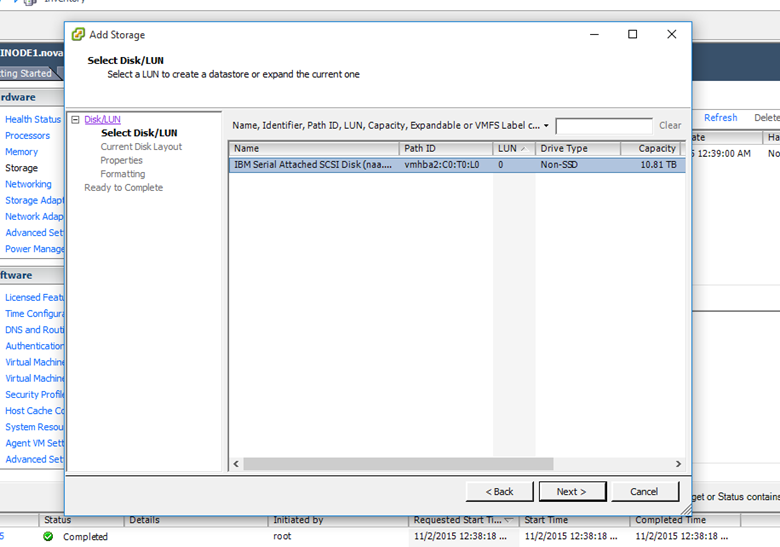

Esxi sunucuda add storage diyerek datastore ekleme işlemini tamamlayalım.

Next diyerek devam edelim.Oluşturmuş olduğumuz 10.81 tb alan karşımıza gelmekte next diyerek devam edelim.

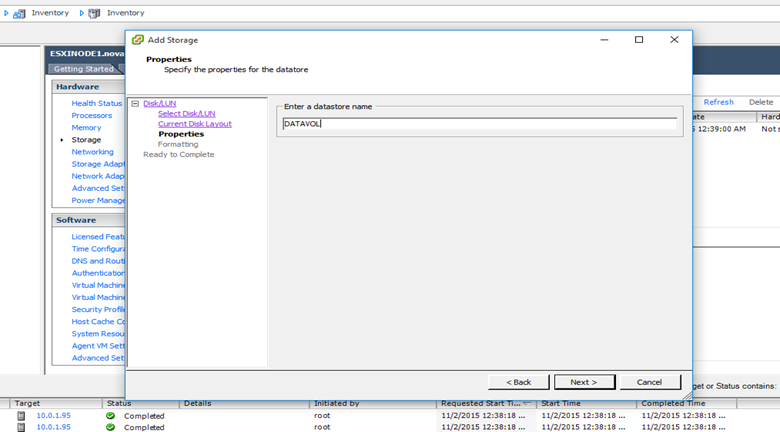

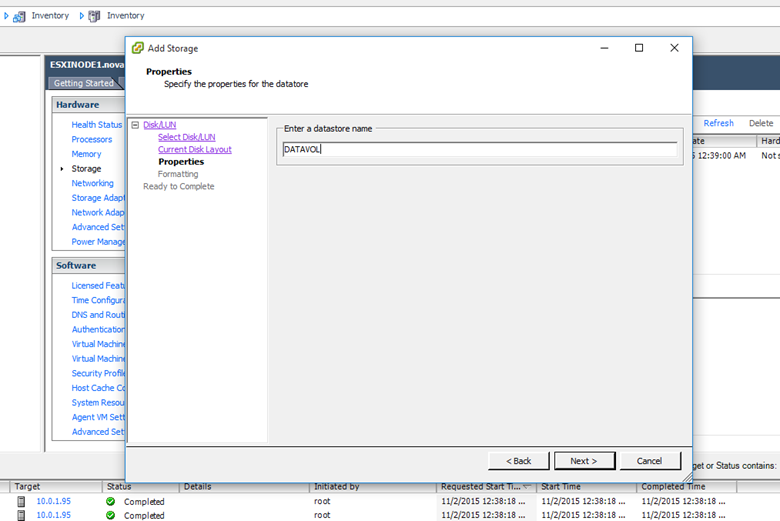

Datastore için storwize üzerinde oluşturmuş olduğum volume la aynı isimi veriyorum, isteğe bağlı isterseniz değiştirebilirsiniz.

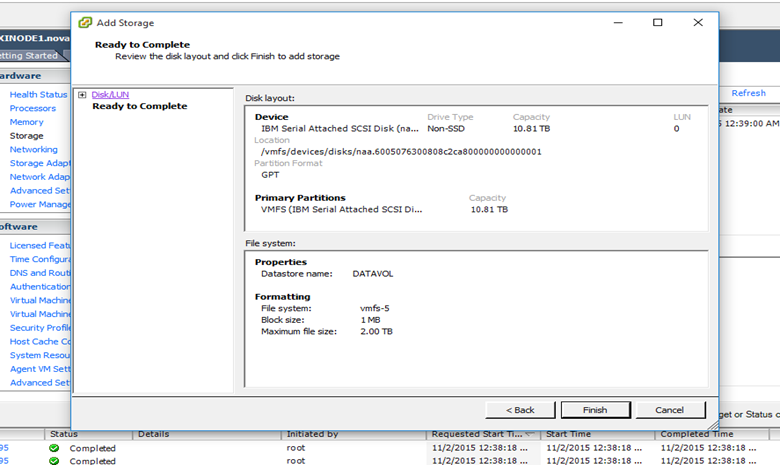

Finish diyerek volume ekleme işlemini bitiyorum.

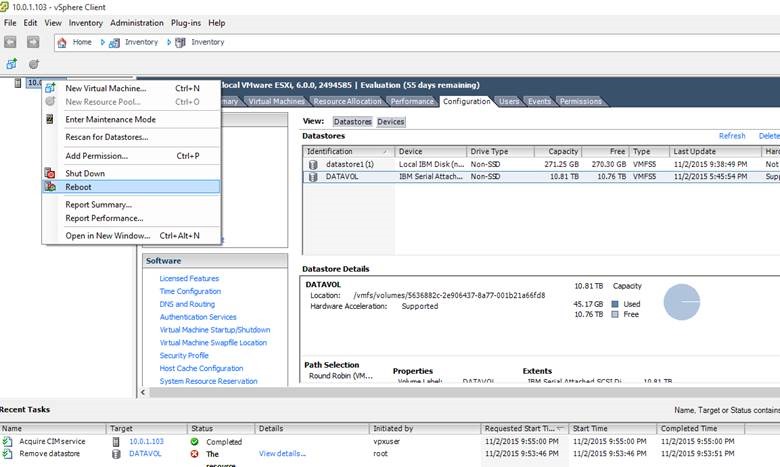

Refresh yaptığımda eklemiş olduğum volume’In geldiğini görüyorum.Bu işlemi her iki esxi sunucu üzerinde gerçekleştiriyoruz.

Şimdi artık Vcenter kurulumuna geçebiliriz.

3) Vcenter 6.0 kurulum ve konfigurasyonu

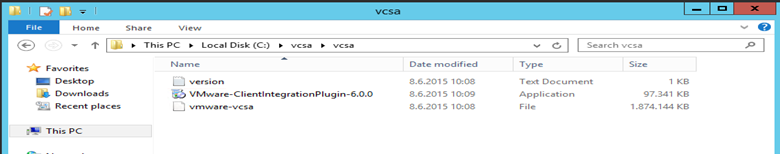

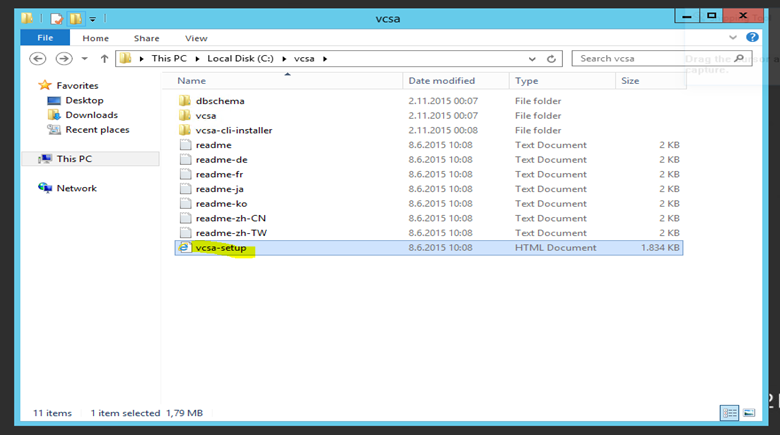

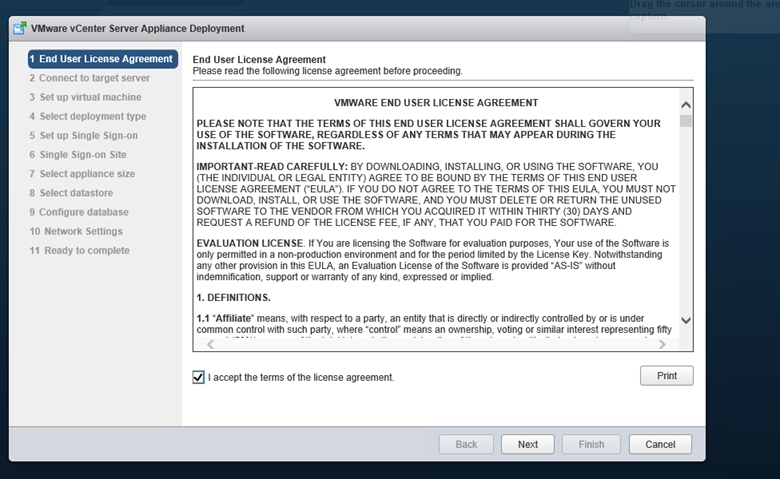

Vmware sitesinden VMware-VCSA-all-6.0.0-2800571.iso yu indiriyoruz.İsterseniz windows isterseniz opensuse tabanlı vcenter kurulumu yapabilirsiniz.Appliance genelde daha stabil ve perfomanslı olduğu için opensuse yi tercih ediyorum.

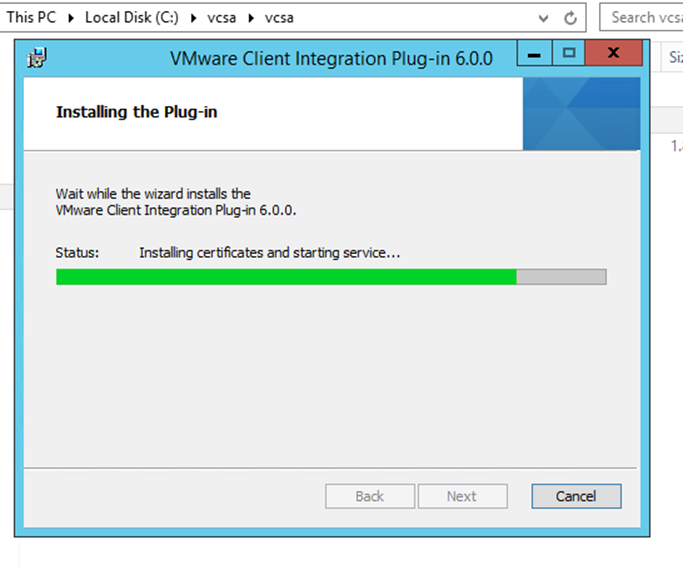

Appliance kurmak için öncelike bir plugin kurmanız gerekli , appliance kurulumunu bir browser gerçekleştireceğimiz icin bu gerekli,zaten vcenter artık tamamen browser üzerinden kullanılıyor,vsphere client da da kullanabiliriz fakat bazı işlemlerini gerçekleştirmeniz kısıtlıdır.O yüzden browser üzerinden kullanmak daha doğru olacaktır.

VMware-VCSA-all-6.0.0-2800571.iso yu mount edip içerisinde client integration plugin I kuruyorum.

Plugin kurulumunda sonra iso içerisinden vcsa-setup’I çalıştırıyorum

İnstall appliance diyerek kurulumu başlatıyorum.

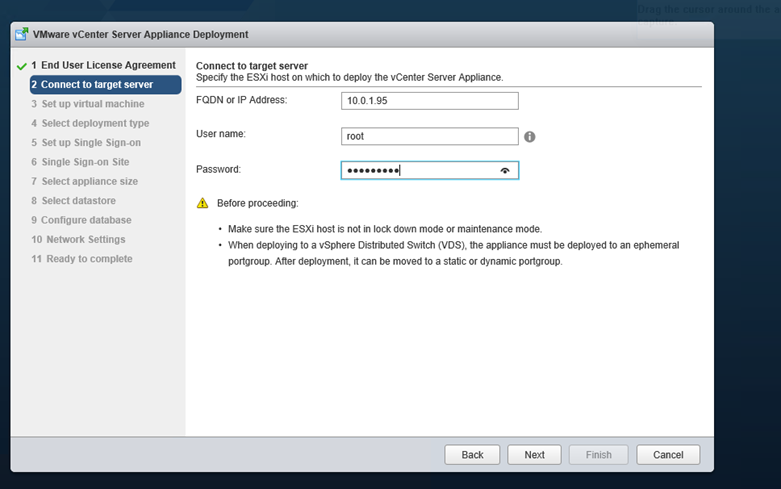

Bu kısımda vcenter I kurabilmemiz için bizden host bilgisi istiyor herhangi bir host ip adresi ve root şifresini yazarak ilerliyorum karşıma çıkan sertifikayı kabul ederek devam ediyorum.

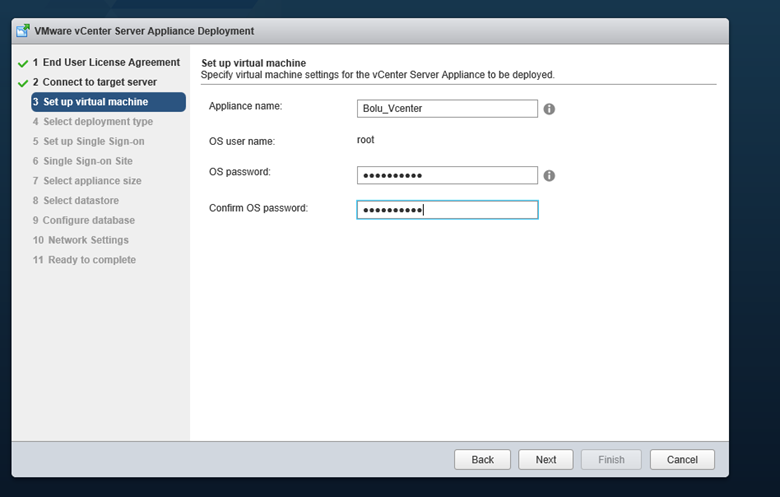

Bu adımda Vcenter için bir isim belirtiyorum host üzerinde bu vm adıyla inventory da görünecektir.Buradaki root opensuse nin yani linux’ın root şifresidir.

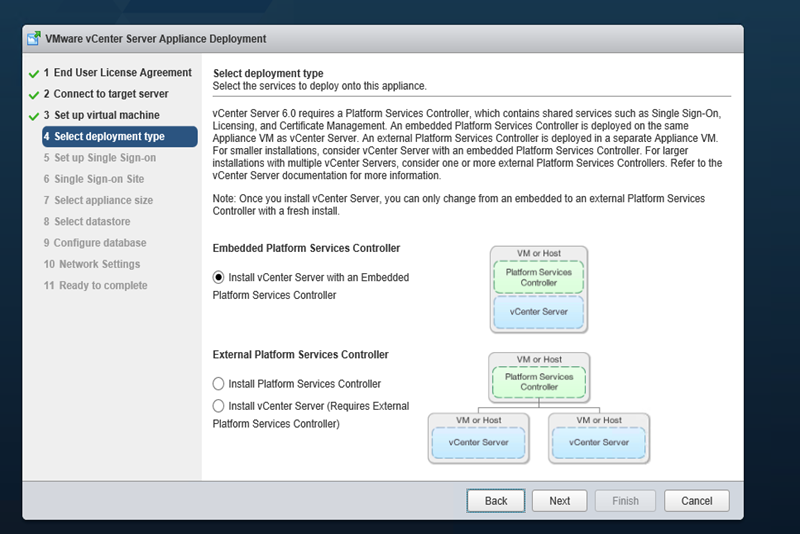

Kurulum tipi olarak embedded I seçiyorum gerekli olan tüm servis ve bileşenleri bi arada kuracağım, isterseniz bu servisleri ayırabilirsiniz.

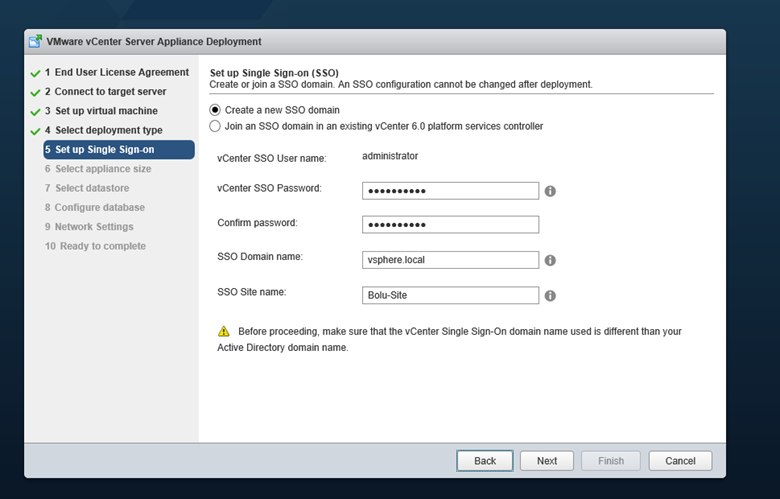

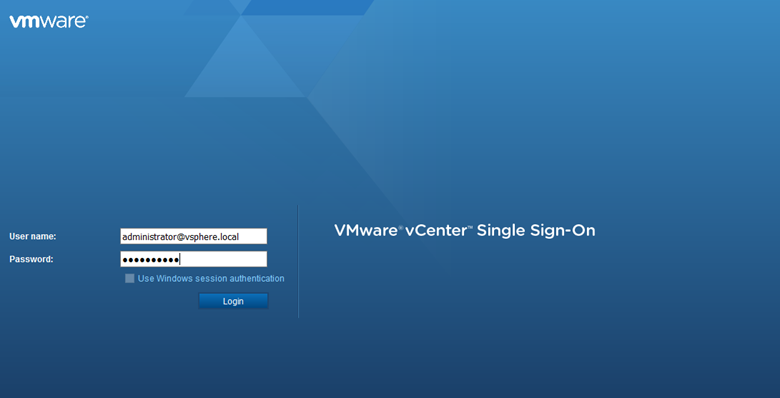

Bu adımda önemlidir.Vcenter a erişim bir sso domain oluşturmamız gerekiyor.İsterseniz kendi domaininizi belirtebilir vey a mevcut bir sso ya dahil edebilirsiniz.Ben yeni bir sso domain oluşturacağım.

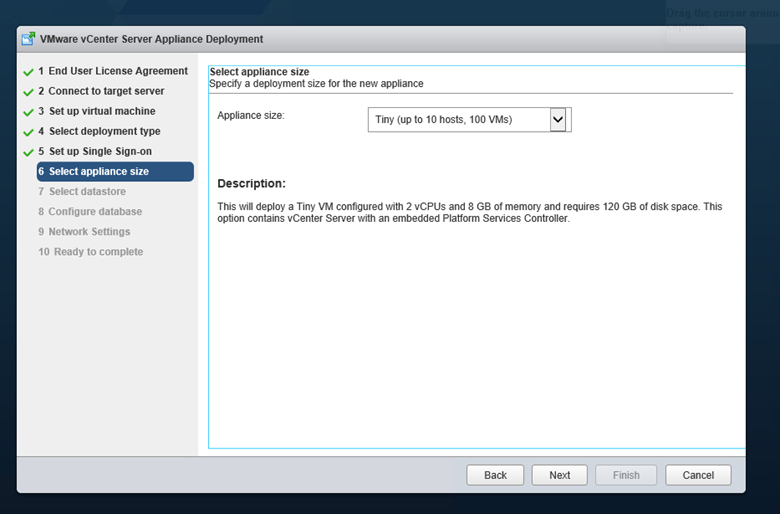

Burada kaç host ve vm kullanmayı planlıyorsanız appliance size ını ona göre seçebilirsiniz.Ben 2 host ve 100 vm düşündüğüm için bu planı seçiyorum.

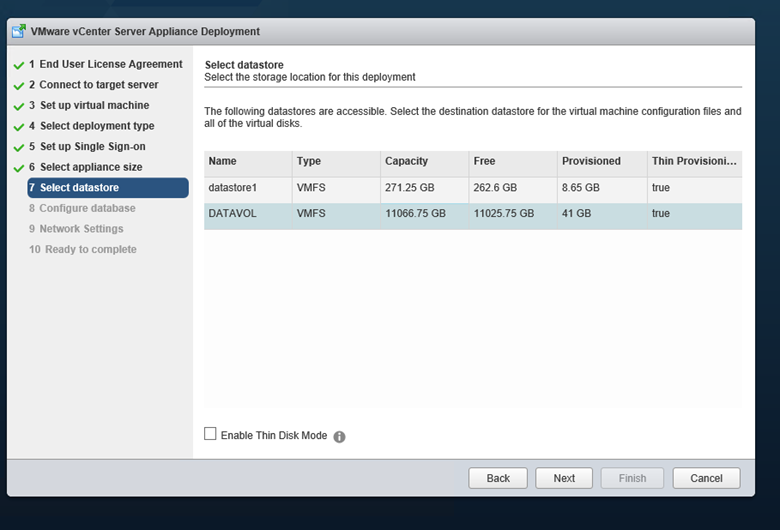

Datastore olarak storwize üzerinde oluşturmuş olduğum datastore u seçiyorum.Thin disk ve thick disk seçeneği var.Thin disk de storage üzerinde bir alanı direkt olarak ayırmayıp kullanacağı alan arttıkça yer kaplar, thick disk ise yani bu seçeneği seçmezseniz direkt olarak ihtiyaç duyduğu alanı ayırıp storage üzerinde blok olarak alır.

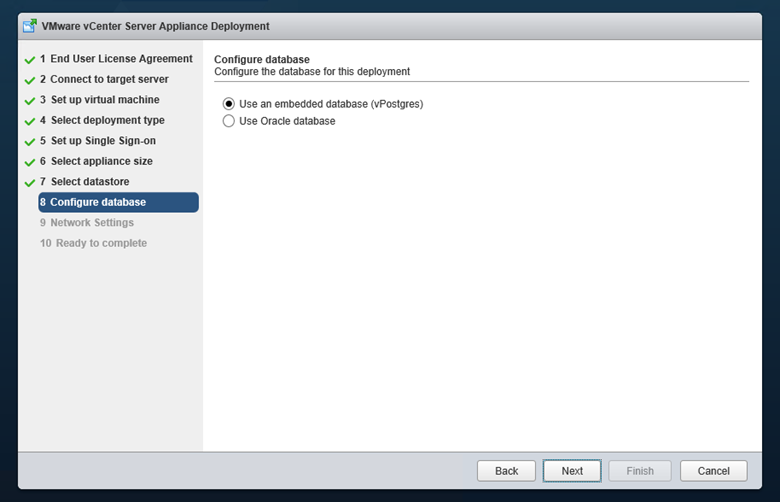

Database seçimi olaram embedded database vpostgresi seçip devam ediyorum.isteğe bağlı olarak bir oracle database’inizde gösterebilirsiniz.

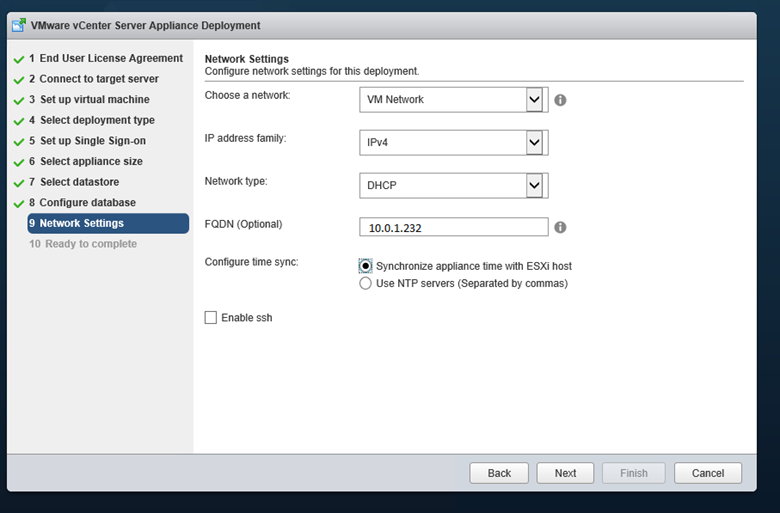

Bu kısım yine önemlidir.Appliance I hangi network den konuşturacağınızı , fqdn adını ve ip adresini belirteceğiz.Özellikle fqdn adı verirken network de unique yani benzersiz bir isim verdiğinize emin olun.Ntp server kısmında da ntp bilgilerini esxi host üzerinde tanımlamış olduğumuz ntp den çekebilir vey a manuel olarak girebilirsiniz.

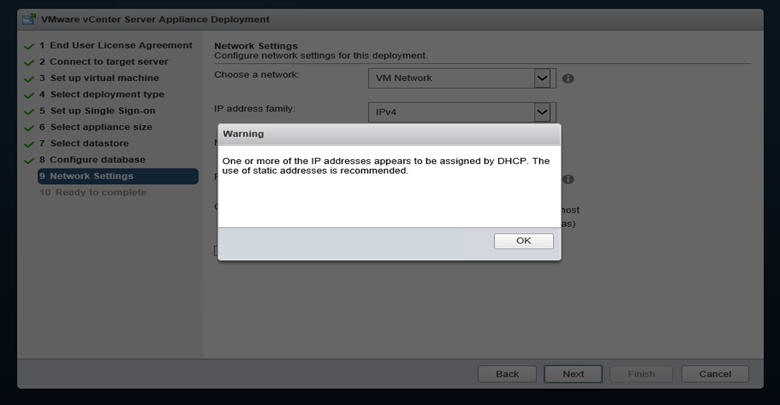

Dhcp yi seçtiğim için beni static ip kullanmam konusunda uyarıyor, eğer dhcp kullanıyorsanız kesinlikle bu ip adresi ve mac adresini reserve edin, network de başka bir cihazın almayacağından emin olun özellikle dns de, eğer bununla ilgili bir hata alırsa kurulumda devam etmeyecektir.

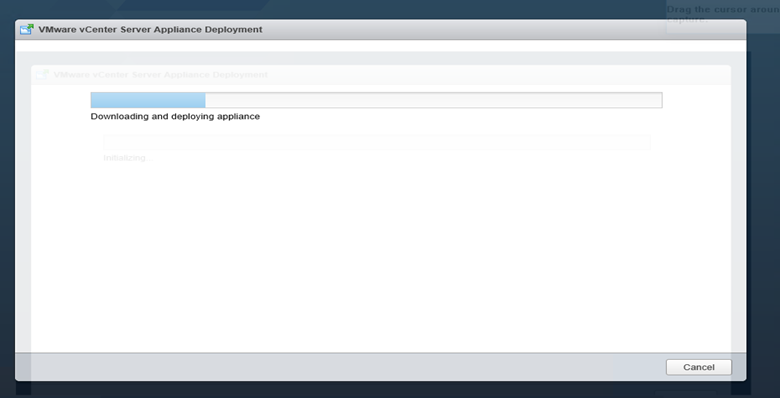

Kurulum başlıyor.

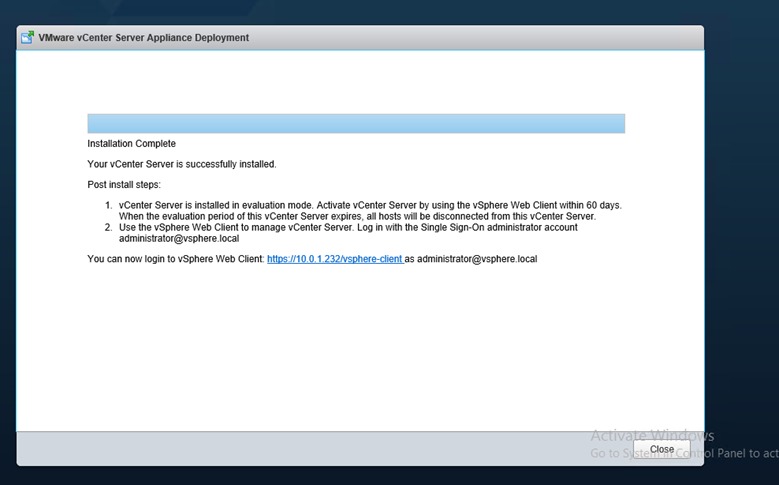

Vcenter kurulumu tamamlandı.Şimdi vcenter a login olmak için yukarıdaki adresten giriş yapalım.

4) HA Konfigurasyonu

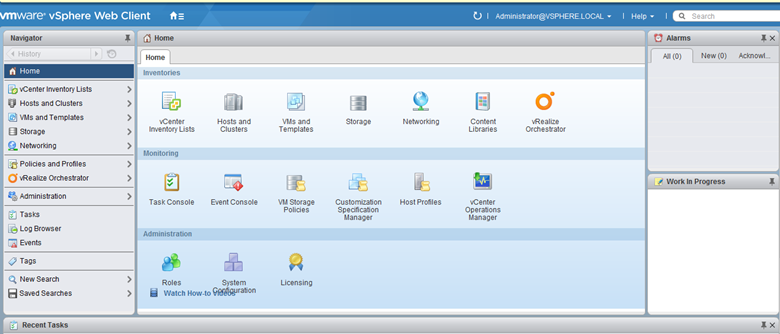

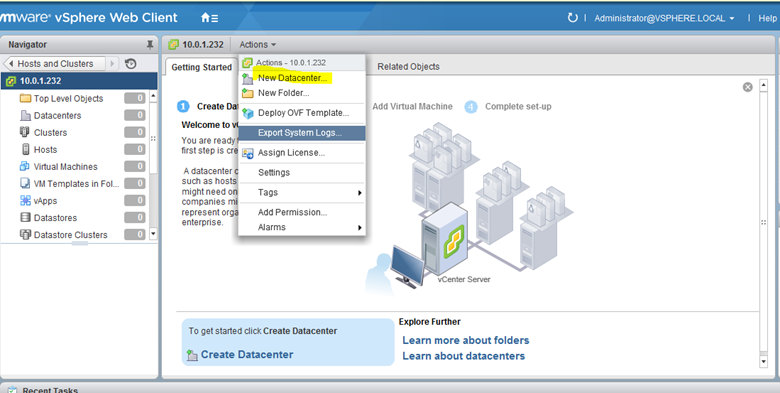

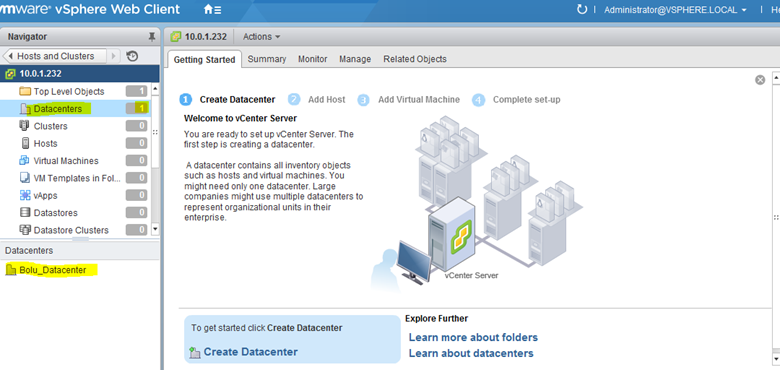

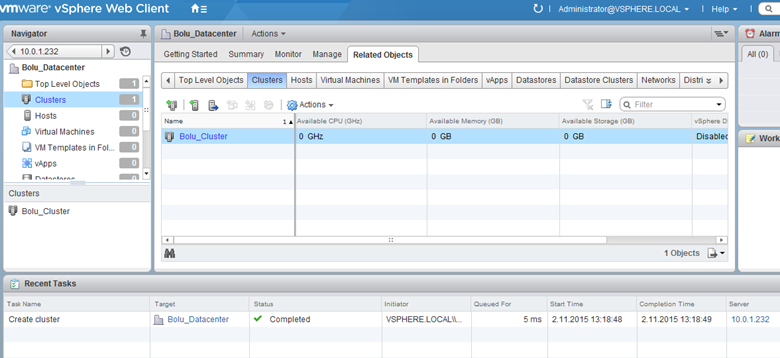

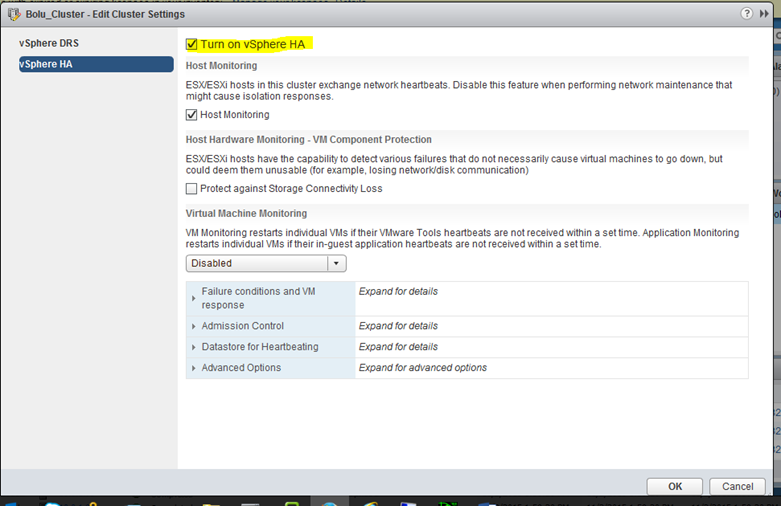

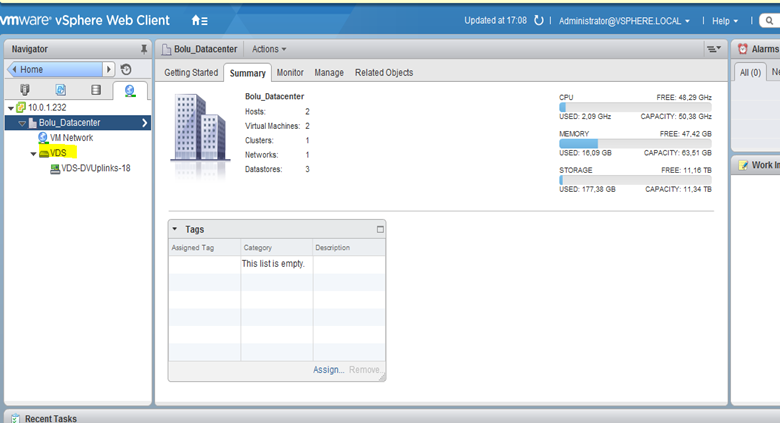

Vcenter kurulum amacımız bir fully automated bir ha yapısı oluşturmak ve vdistributed switch özelliği kullanabilmek.Ha yapısı öncelikle bir datacenter oluşturuyorum ve sonrasında bir cluster oluşturup host’ları bu cluster’a dahil edeceğim.

Datacenter’ımız oluşmuş durumda şimdi bir cluster oluşturuyoruz.

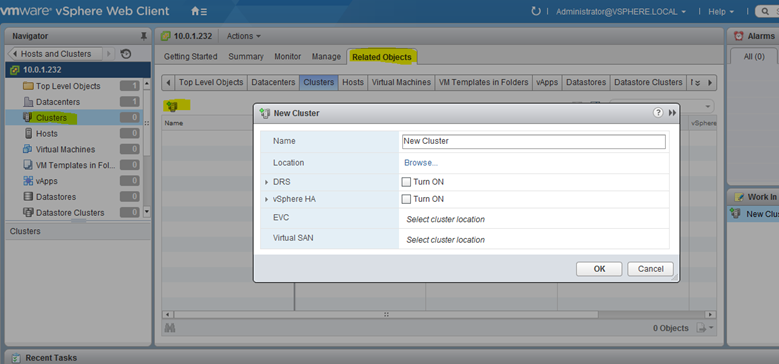

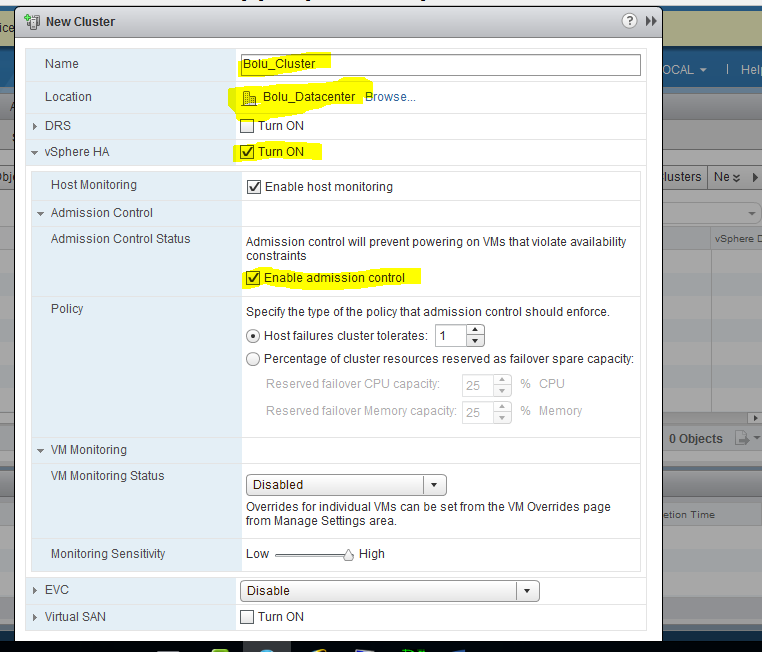

Hosts and clusters’a gelip add cluster simgesine tıklayarak cluster oluşturma paneline giriş yapıyorum.

Cluster’a tanımlayıcı bir isim veriyorum.Vsphere HA işaretliyorum.DSR I kullanmayacağım.DRS fiziksel sunucularıdaki tüm kaynakları belirlemiş olduğumuz kriterlere göre otomatik olark yük dağılımını yani loadbalance yapmanıza sağlayan servistir.Vm’in kaynak kullanımına göre sanal sunucuyu bir host üzerinden diğer hosta otomatik olarak taşıyalabilir Storage değişimi yapabilir.

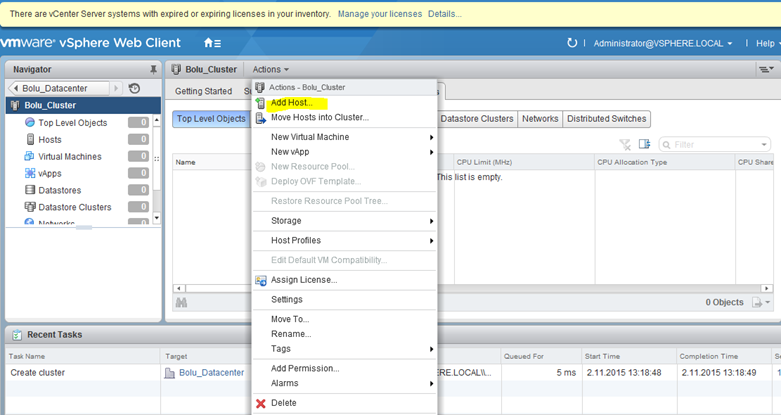

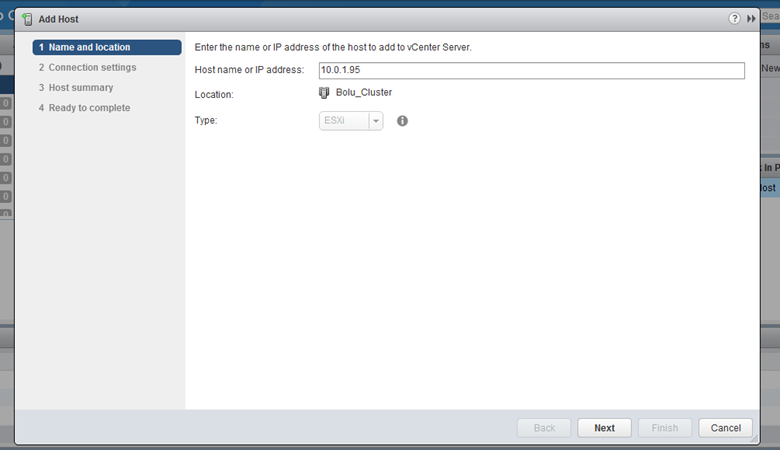

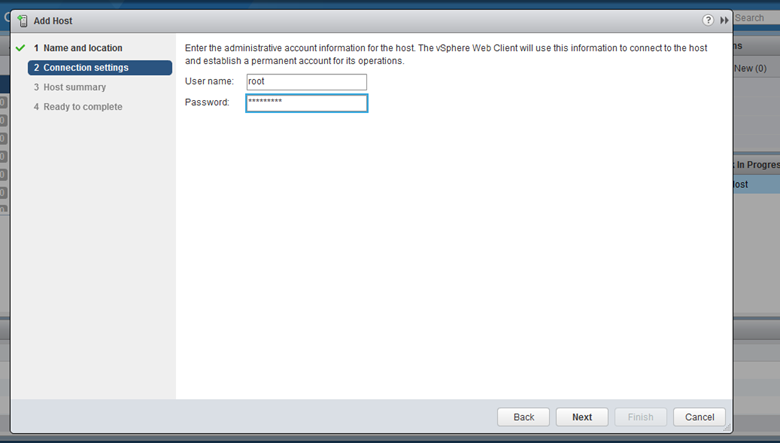

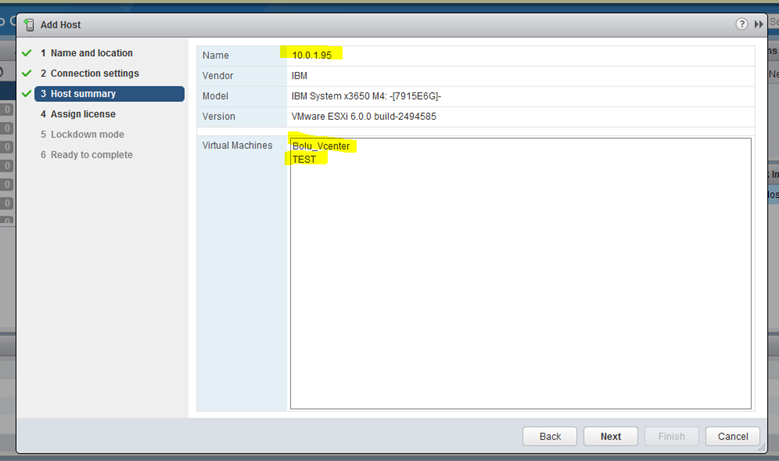

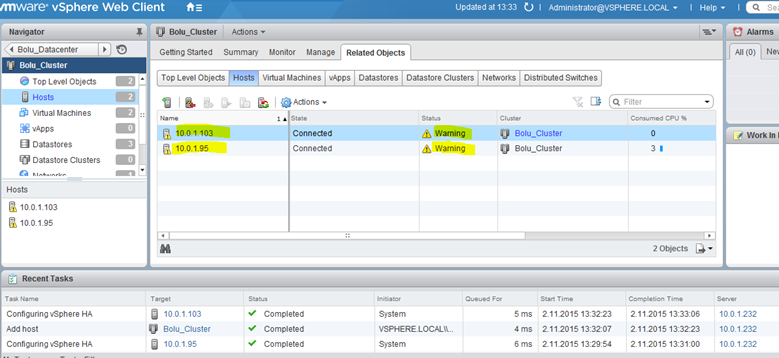

Cluster ımız oluştu şimdi hostları cluster’a dahil edeceğiz

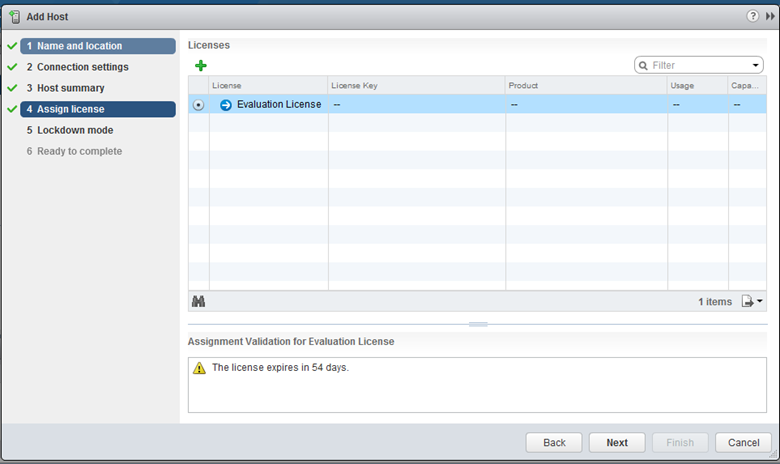

Lisans atamasını gerçekleştiriyoruz.Şuan için Evaluation lisansı kullanacağım, 54 gün sonra bu lisans kullanım hakkını dolduracaktır.İstersek + ya basarak satın almış olduğumuz lisansları girebililriz.

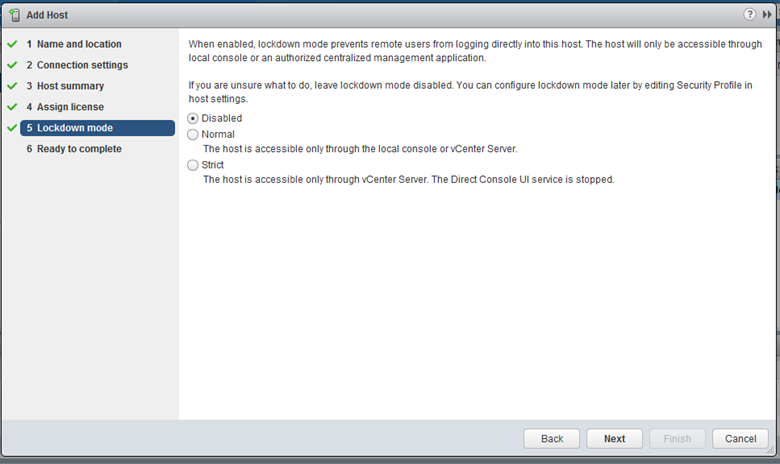

Finish diyerek host ekleme işlemini tamamlıyorum aynı işlemleri iki sunucu için de gerçekleştiriyorum.

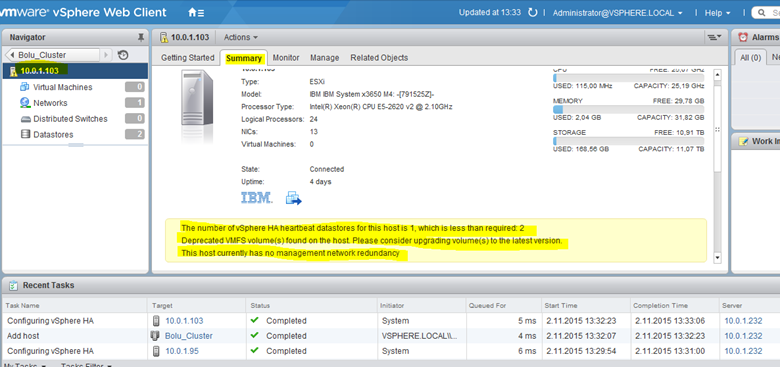

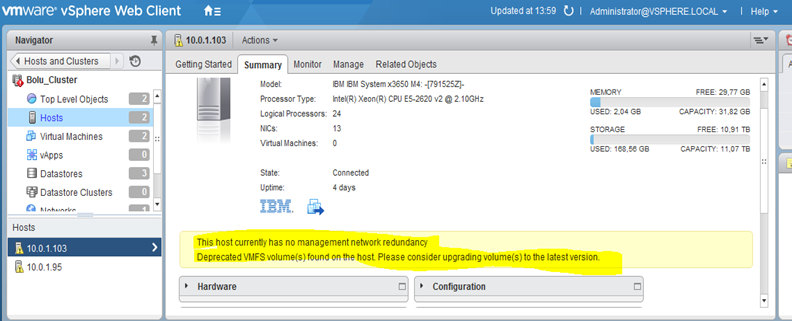

Sunuculara ha agent’lar gönderildi.Ve ekleme işlemi tamamlandığı görüldüğü gibi bizi uyarıyor.Yani henüz stabil şekilde cluster’ın sağlayabileceğimizden emin olmamız gerek.Bu uyarılara göz atalım.

Host’lardan birinin üzerine gelip summary bölümüne geliyorum.

Toplam da 3 konuda bizi uyarmış, bu uyarıları gidermemiz sağlıklı bir ha yapısına sahip olacağımızı garanti eder.

İlk uyarıda 1 den fazla shared storage olması gerektiği konusunda bizi uyarıyor.Ben storwize üzerinde tek bir volume oluşturduğum bu uyarıyı advance options da bir tanımlama yaparak gidereceğiz.

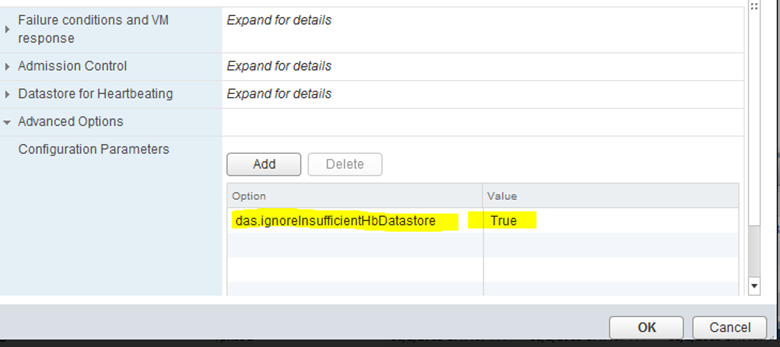

das.ignoreInsufficientHbDatastore.

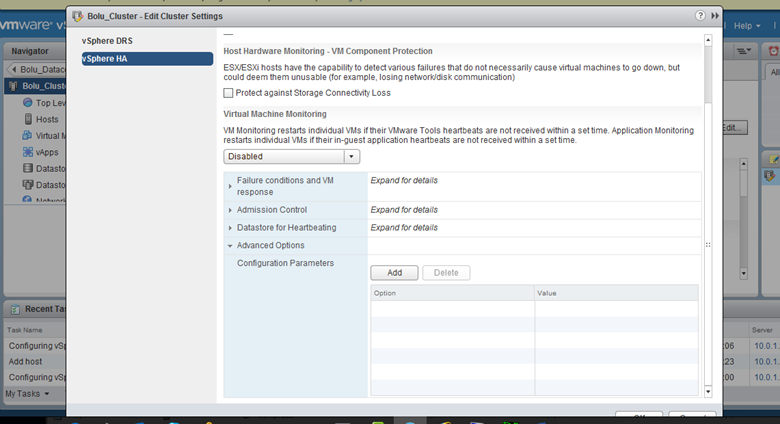

Oluşturduğumuz cluster’I seçtikten sonra edit diyerek advanced options bölümüne geliyoruz.

Add diyerek parametreyi tanımlıyoruz.

Bu işlemden sonra HA yı disable edip tekrar etkinleştiriyorum.

Bu hatayı giderdikten sonra geriye kalan uyarılara göz atıyoruz.

Management network de ya tek ethernet kullanıyoruz vey a ethernet’lerden birinde uplink şuan da yok.

İkinci uyarıda oluşturmuş olduğumuz volume önerilmez olarak görüyor.Esxi sunuculara datastore ekleme işlemi yaptıktan sonra restart işlemi yapmamıştım.Aslında gereken bir durum değil.Bunun için host’ları bir kere restart ediyorum.Ama öncesinde bu host üzerinde management network de uplink ve ethernet kontrolünü sağlıyorum.

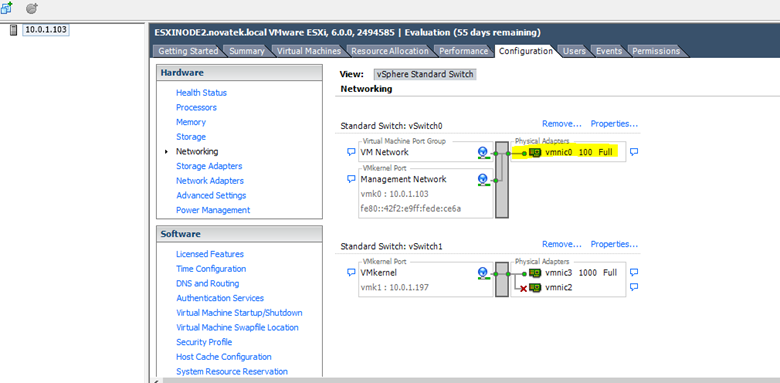

Bunun için vsphere client ile 10.0.1.103 nolu sunucuya bağlanıp networkinge kısmına geliyorum.

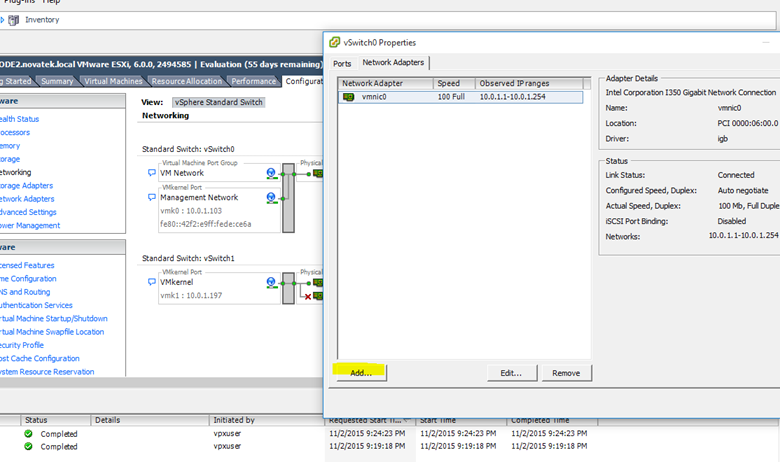

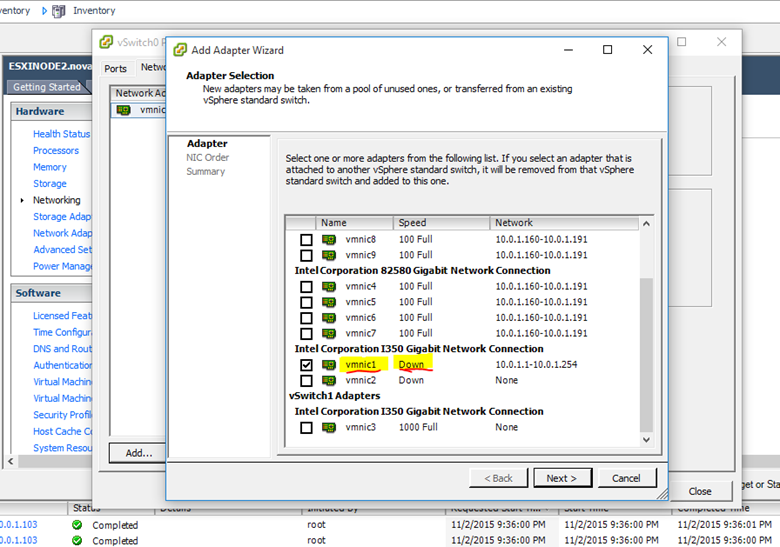

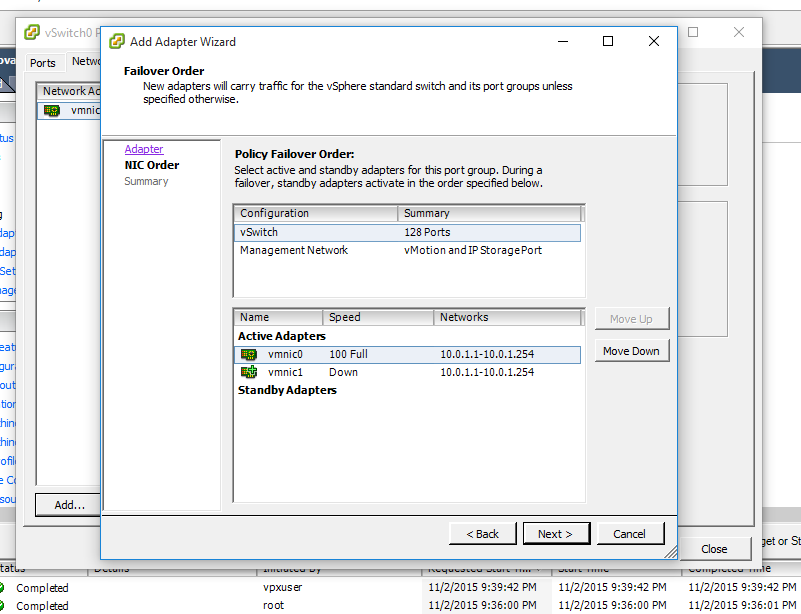

Manamgent network için kullanılan physical adaptors sayımız 1 adet görünüyor bunu arttırmak için properties e giriyorum.

Vmnic1 adaptor’ü fiziksel sunucu üzerinde 2 nolu ethernet’im şuan üzerinde bir uplink bulunmuyor o yüzden down durumda, yani fiziksel switch ile ethernet arasında bir kablo yok.

Vmnic1 I seçiyorum ve devam ediyorum, 2.nolu ethernet kartıyla fiziksel switch arasına bir data kablosu bağlayıp uplinki sağlıyorum.

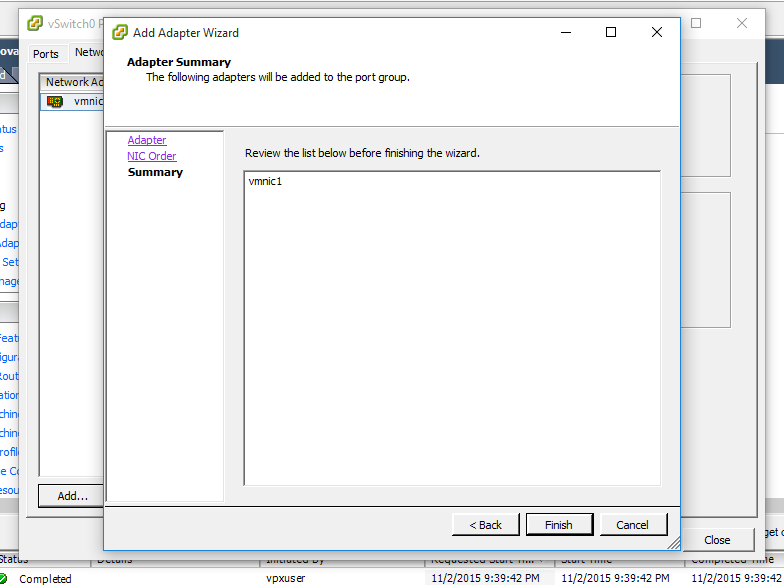

Next diyerek devam ediyorum.

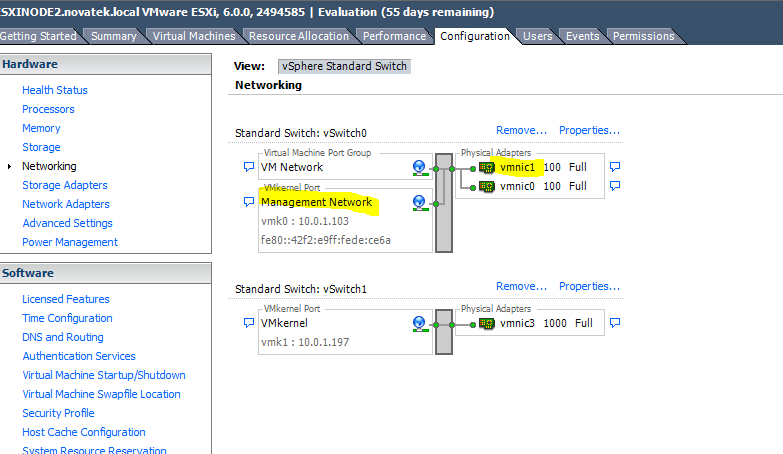

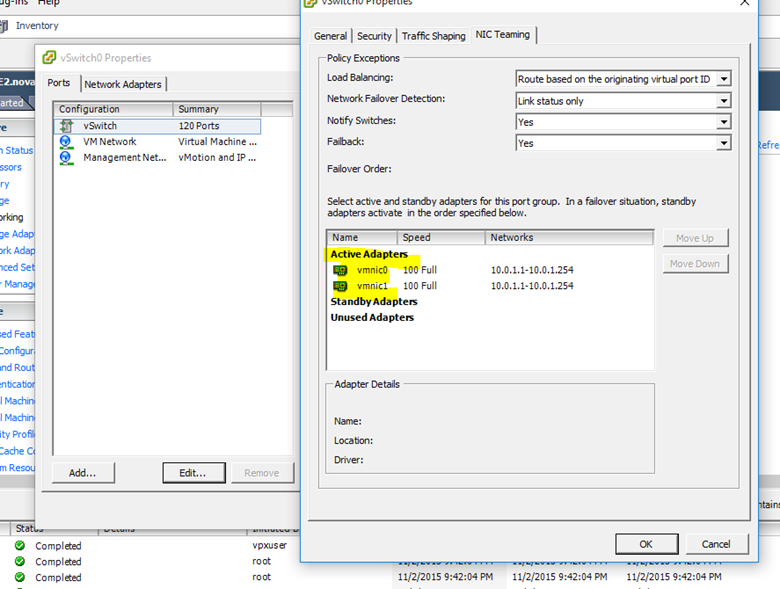

Management network’ün bağlı olduğu vswitch0 üzerinde iki adet vmnic adaptor ile uplink yedekliğini sağlamış olduk.İlerki aşamada tüm network’leri ayırıp her bir network için ayrı vswitch ve vds kullanacağız.İsterseniz lacp ile daha spesifik bir şekilde uplink yedekliğini ve bandwith arttırımı sağlayabilirsiniz.Management network’üm için iki adet vmnic benim için yeterli.

Management network’ün bağlı olduğu vswitch0 üzerine baktığımızda iki ethernet’inde aktif şekilde kullanıldığını görüyoruz.Uplink’lerinizinden birine birşey olsa bile diğer ethernet üzerinden esxi sunucunuza erişim devam edecektir.

Bu sırada diğer uyarıyı gidermek için esxi sunucularımı bir kere restart edebilirim vey a daha basit bir yöntemle eklemişim storage’I kaldırıp tekrar ekleyebilirim.Bu işlemi içinde bir sanal makina barındırmıyorsanız o an için yapabilirsiniz.

Host üzerine sağ tıklayıp reboot diyorum.

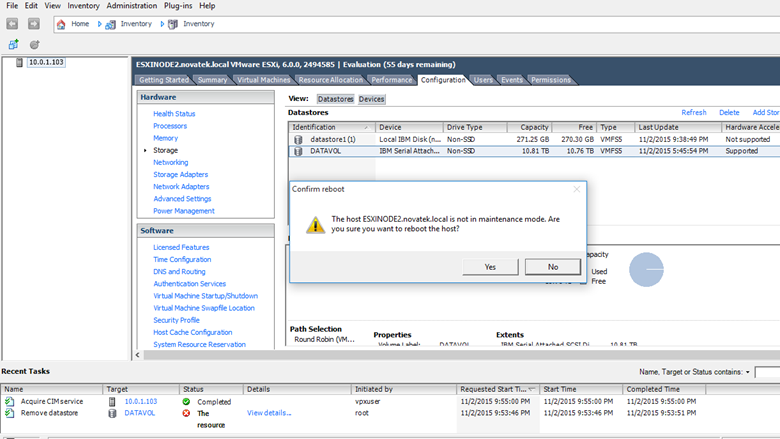

Reboot etmek istediğiniz node maintenance modda değil, reboot etmeyi istiyor musunuz diye soruyor.

Yes diyerek devam ediyorum.Bu uyarıyı neden veriyor onu açıklayayım.

Eğer bir host’u reboot etmek istersek öncelikle bakım moduna alırız bu olay bizim maneul gerçekleştirmek istediğimiz bir durumdur, ve bu sayede host üzerinde barındırdığı sanalları diğer sunucuya taşır bir ha yapısı ve düzgün yapılandırılmış vmotion network tanımınız var ise.Ve ya üzerinde vm’leri maneul taşımamız gerekir.

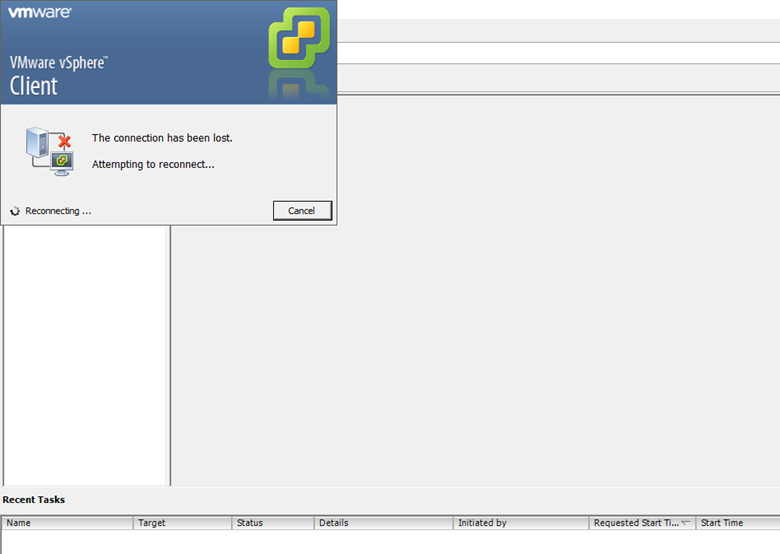

Şuan da host bağlantımız düştü.Sunucu açılana kadar yeniden bağlanmayı deneyecektir.

Eğer datastore’a eklemiş olduğumuz volume’e içerisinde bir data vey a vm olmasaydı bu işlemi add/remove datastore işlemi çözebilirdik.Fakat içerisinde aktif kullanılan data olduğu için bu işleme izin vermeyecektir.Bu yüzden sunucuyu bir kereye mahsus reboot ediyoruz.

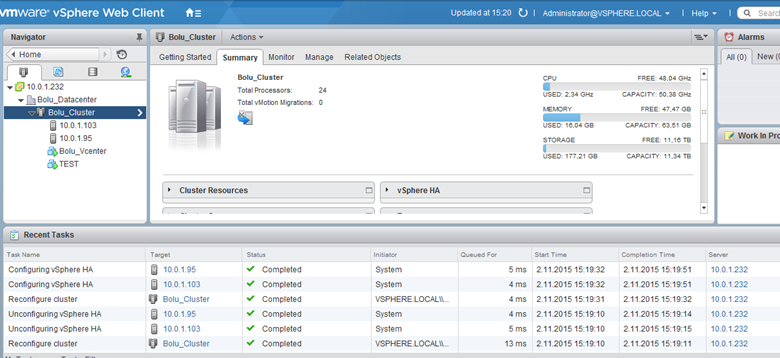

Sunucumuz açıldıktan sonra tekrar vcenter’a girip summary kısmında hata vey a bir uyarı varmı control ediyoruz.

Cluster’ımızda hiç bir problem yok, bundan sonraki aşamada en önemli kısım, yani network tarafını configure edeceğiz.

6) Networking ve lacp konfigurasyonu

HA’ın düzgün çalışabilmesi ve stabil bir network bağlantısı için network’leri gruplandırmak ve yedeklilik sağlamak gerekir.Herkesin network konfigurasyonu farklıdır, isterseniz vlanlara bölebilir, subnet’lere bölebilir vey a complex bir yapı kullanabilirsiniz.

Benim toplamda 12 adet ethernet kartım var, var iki sunucuda da vswitch’leri ve vds I benzer şekilde konfigure edip iki taraf içinde bir bütünlük sağlayacağım.

Her sunucuda da toplam 12 adet ethernet kartım bulunuyor.Bunları şu şekilde tanımlayabiliriz.

Vmnic0 – Fiziksel sunucu üzerinde 1.ethernet portu

Vmnic1 – “ 2.ethernet portu

Vmnic2 – “ 3.ethernet portu

Vmnic3- “ 4.ethernet portu

Vmnic4- “ 5.ethernet portu

Vmnic5- “ 6.ethernet portu

Vmnic6- “ 7.ethernet portu

Vmnic7- “ 8.ethernet portu

Vmnic8- “ 9.ethernet portu

Vmnic9- “ 10.ethernet portu

Vmnic10- “ 11.ethernet portu

Vmnic11- “ 12.ethernet portu

Mevcut ethernetlerimi gruplara ayırıp vcenter da farklı network groupları oluşturacağım, buna göre

Vmnic 0,1 à management network için

Vmnic 2-3 à vmotion vmkernel network için

Vmnic,4,5,6,7,8,9,10,11 à vDistributed switch için

VDstributed switch I ne için kullanılırız? Vds ancak ortamda bir vcenter var ise kullanabilirsiniz.Bunun için essential plus lisansına vey a daha üst bir lisansa sahip olmanız gerekir.Eeğer switch üzerinde bir lacp ve benzeri algortimalar kullanmak istiyorsak vds kullanmak zorundayız vswitch’ler bu özellikleri desteklemez.

Ben management ve vmotion için 2 şer adet ethernet ayırıp geri kalan tüm ethernetleri lacp için ayıracağım.Lacp (Link aggregation control protocol) hem link yedekliliği sağlayıp hemde bandwith arttırımı sağlayan oldukça kullanışlı bir protokoldür, tüm management switch’ler bunu destekler.

2 adet farklı vswitch oluşturup 1 adet vds oluşturacağım.

Manegement network – management network için hizmet edecektir.

Vmotion – live migration ve heartbeat cluster için hizmet edecektir.

Lacp – vm network’e hizmet edecektir.

Vcenter’a girip network’lerimizi oluşturalım.

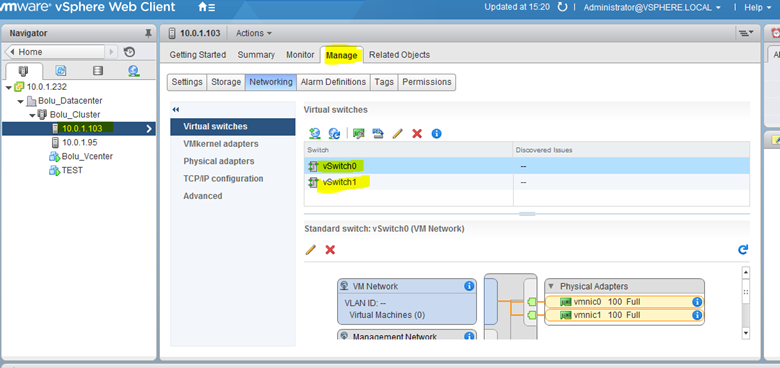

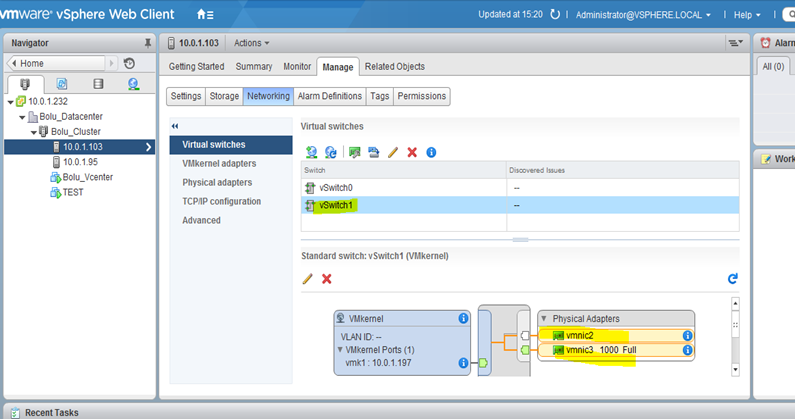

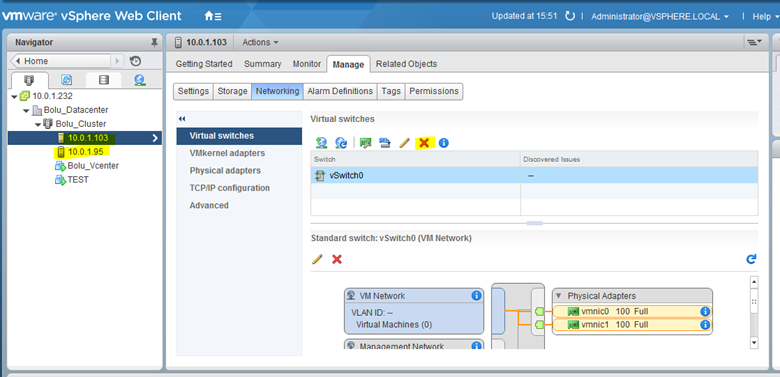

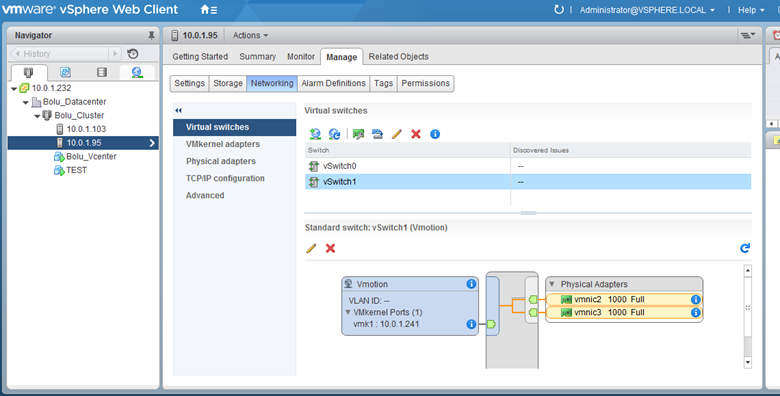

Host’a geklip manage sekmesinden networking tabına geliyorum, virtual switch bölümünde bizim az önce cluster gereksinimleri için link yedekliliği sağlamak için eklemiş olduğumuz manamegement network, vmotion vmkernel network ve bunlara bağlı olan switcihlerimiz var.

Vswitch0 – management network ve vmnetwork için default olarak gelen vswitch’imiz biz vmnic0 ve vmnic1 bu switch’e dahil ettik.

Vswitch1-vmotion vmkernel için kullanılan vswitch’dir ben bu switch’I silip vmotion için bir vss oluşturuyorum.İstersek üzerine vmnic ekleyebiliriz.

Vmotion için kullanacağımız vswitch01 I seçip silmek işlemini gerçekleştiriyorum.

Bu işlemi her iki sunucuda da gerçekleştiriyorum.

Şimdi vmotion için vss oluşturalım.

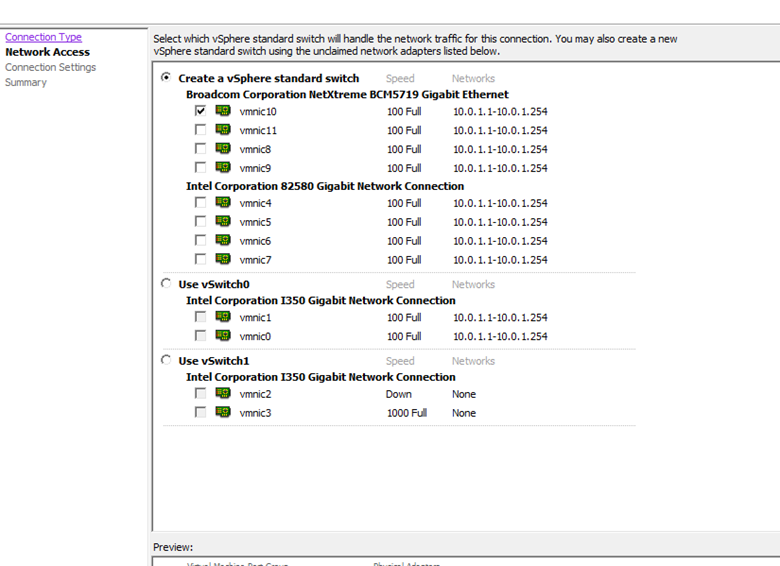

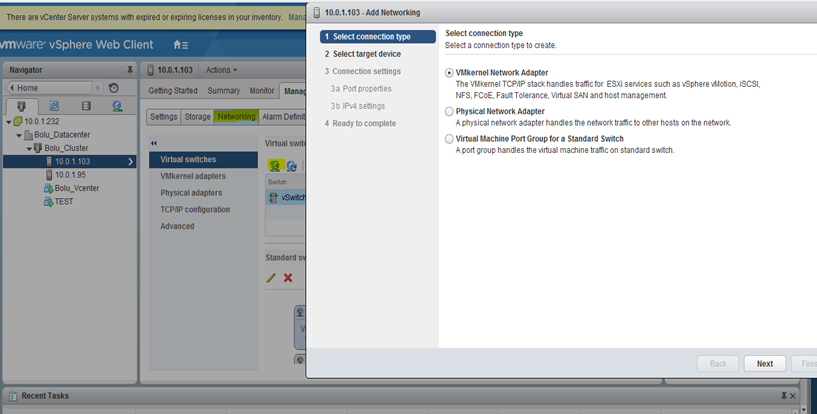

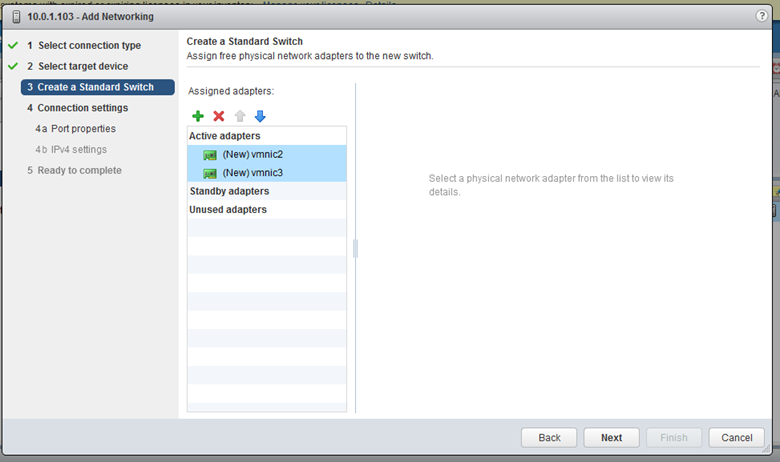

Add networkinge tıklayarak vmkernel network adaptor seçiyorum.

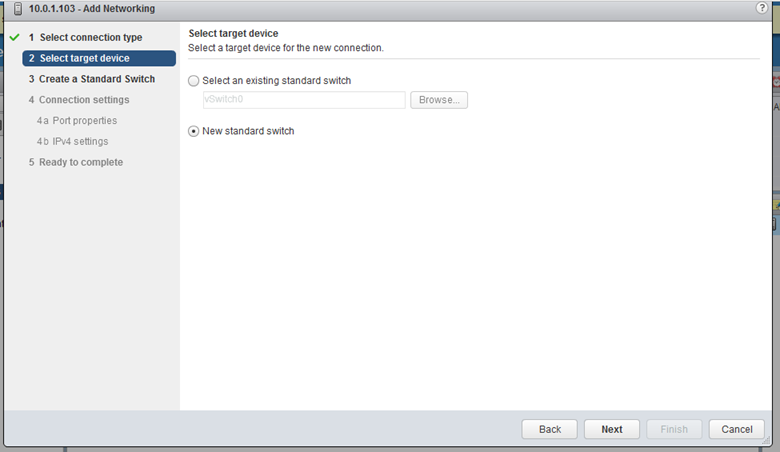

Mevcut bir switch e de bu network’ü tanımlayabilriz ben ayırmak istediğim için yeni bir vswitch oluşturuyorum.

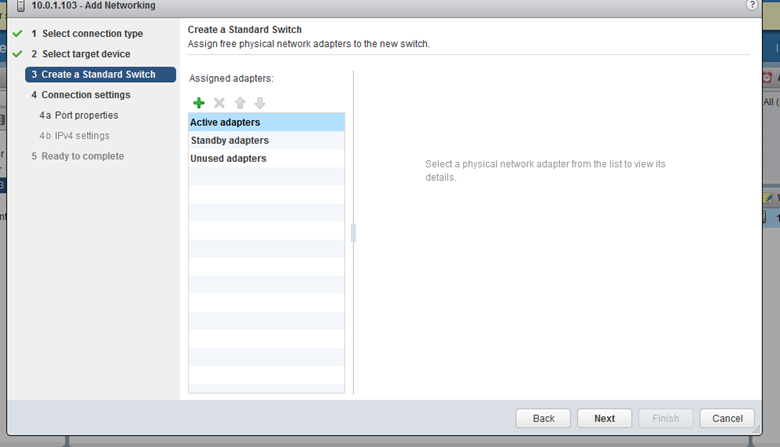

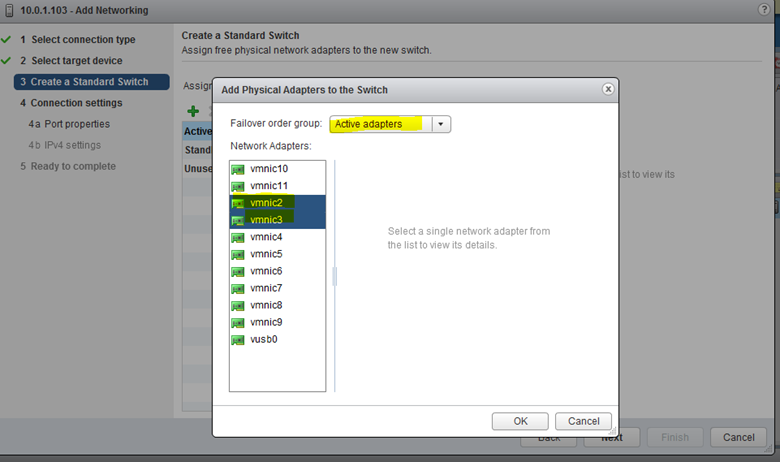

Vmotion için kullanmak istediğin ethernetleri seçiyorum.Failover group olarak active adapters grubunu seçiyorum.

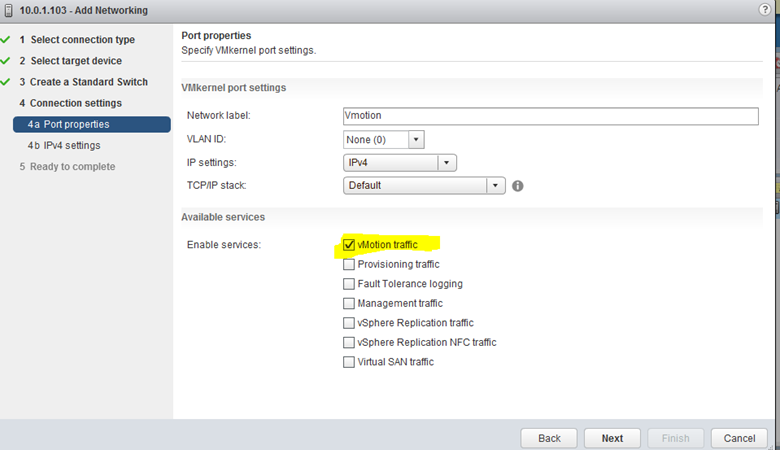

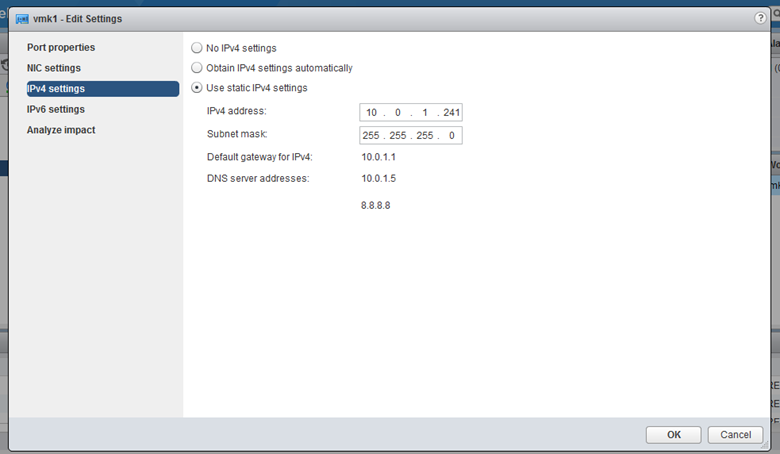

Network label olarak vmotion yazıyorum,herhangi bir vlan a üye yapmayacağım , servisler kısmında vmotion trafiği seçiyorum.

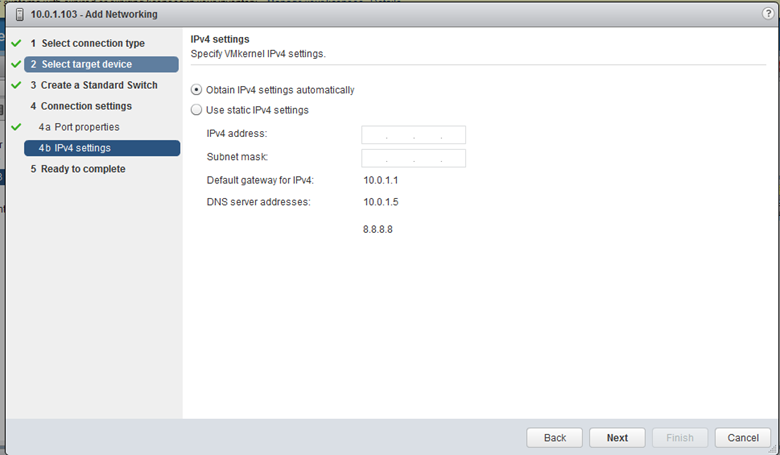

Bu kısım yine önemlidir, vmotion trafiğinin üzerinden geçeçiği ve iki tarafında birbiriyle haberleşeceği network tanımı.Dhcp den ip aldırabilirsiniz vey a static ip verebilirsiniz.

Finish diyerek işlemi tamamlıyorum.

Vswitch1 üzerinde vmotion networkümüz oluştu,

Iki ethernete fiziksel switche bağlandı.Görüldüğü gibi vmnic’ler up olarak görünüyor.

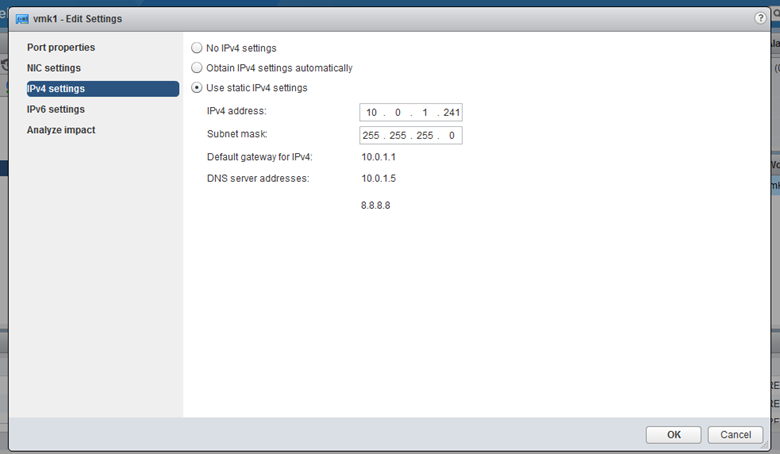

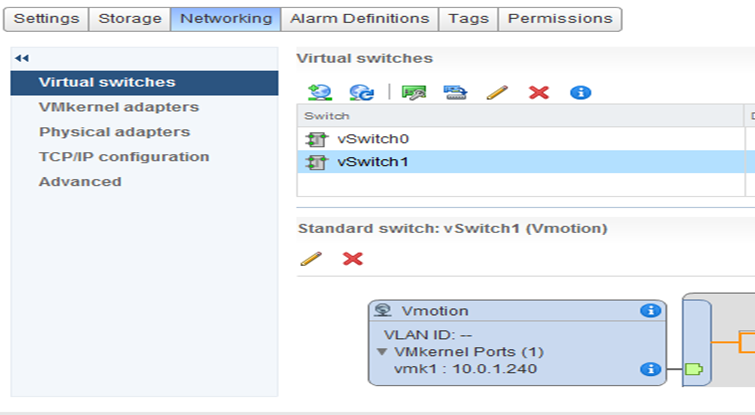

Vswitch oluşturma işlemini her iki sunucuda da aynı şekilde yapıyorum.Sadece ikinci sunucuda ip adresini 10.0.1.240 olarak belirtiyorum.

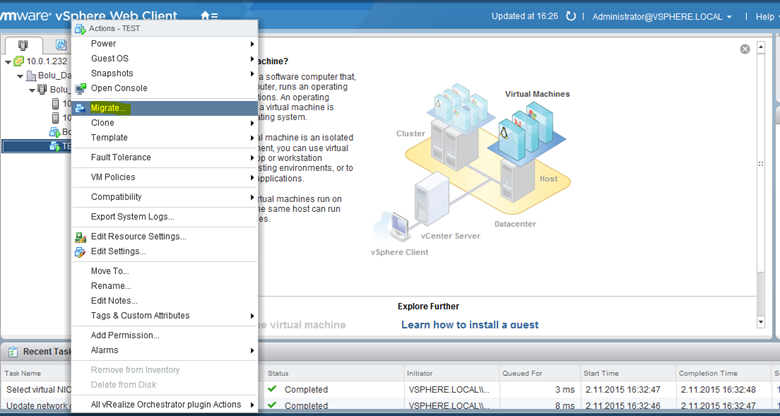

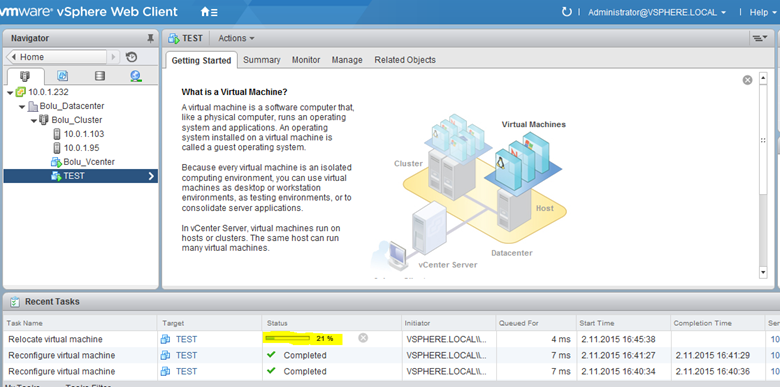

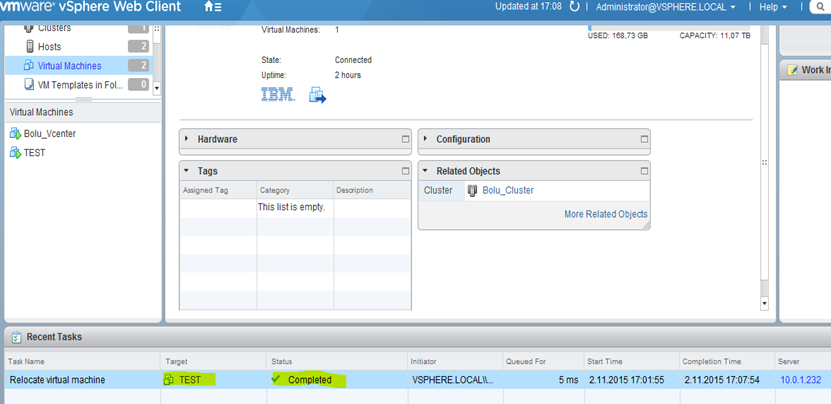

Vmotion networkümüz oluştuğuna göre live migration testini yapalım.

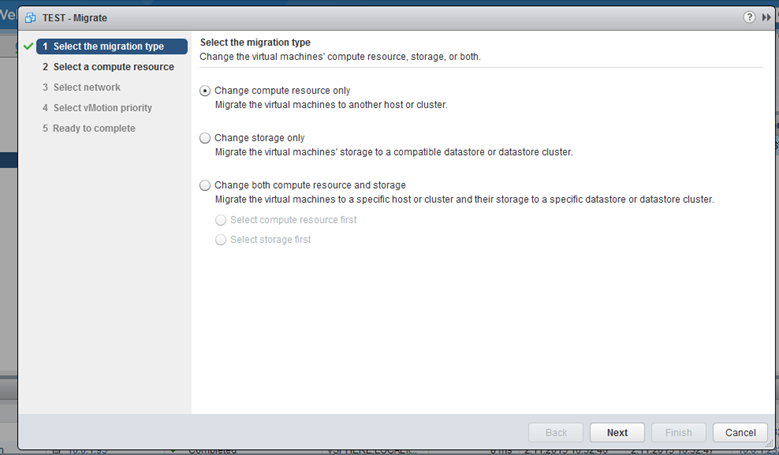

Sanal sunucuya sağ tıklayıp migrate diyorum.

Sadece host değişimi yapacağız o yüzden change compute resource only I seçiyorum.

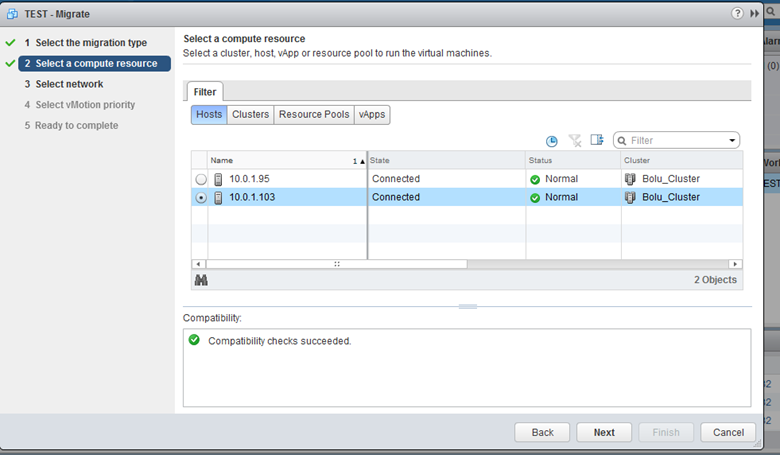

Hangi hosta taşımak istiyorsanız onu seçiyorum.

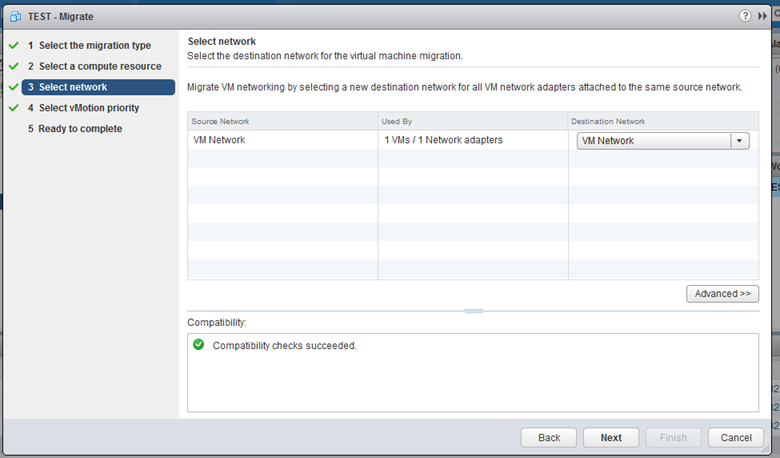

Next diyerek devam ediyorum.

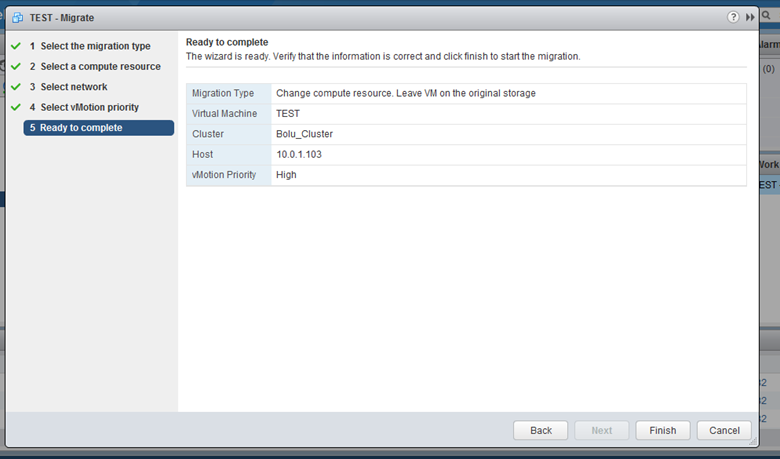

Finish diyerek taşımayı başlatıyorum.

Taşıma işlemi başladı.

Taşıma işlemi başarılı bir şekilde sağlandığına göre vmotion network’de bir sıkıntı yok demektir.Şimdi vmnetwork ü oluşturabiliriz.

1 adet management network oluşturduk.

1 adet vmotion network oluşturduk.

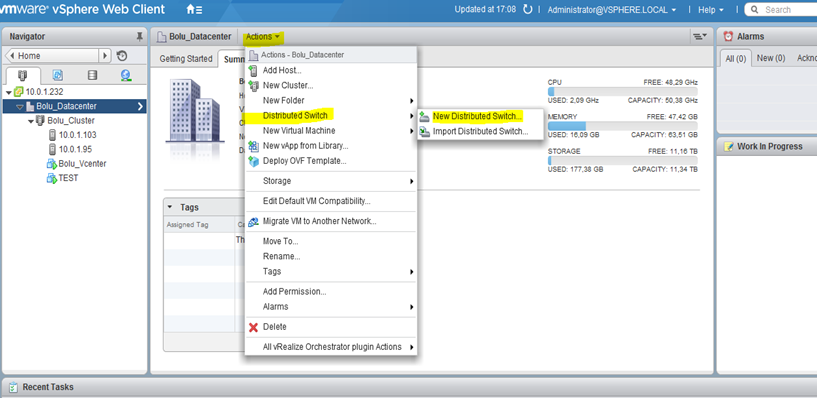

Şimdi de 1 adet vds oluşturup lacp group u oluşturup vmnetwork için network oluşturacağız.

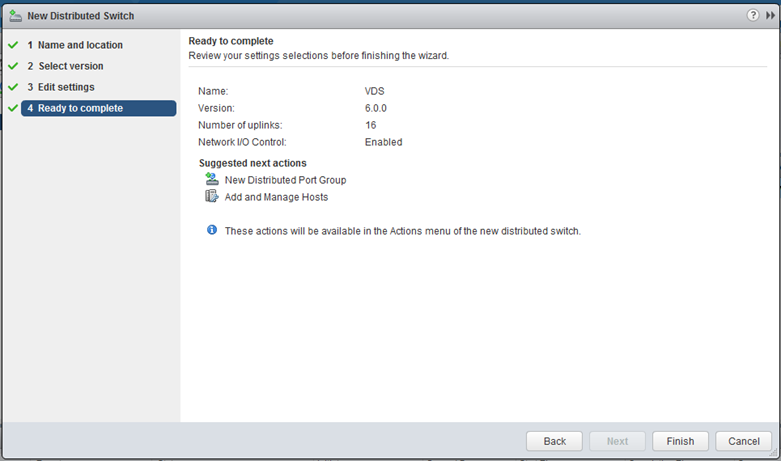

Vcenter a vds oluşturmak için datacenter’I seçip actions kısmında new distributed switchi seçiyorum.

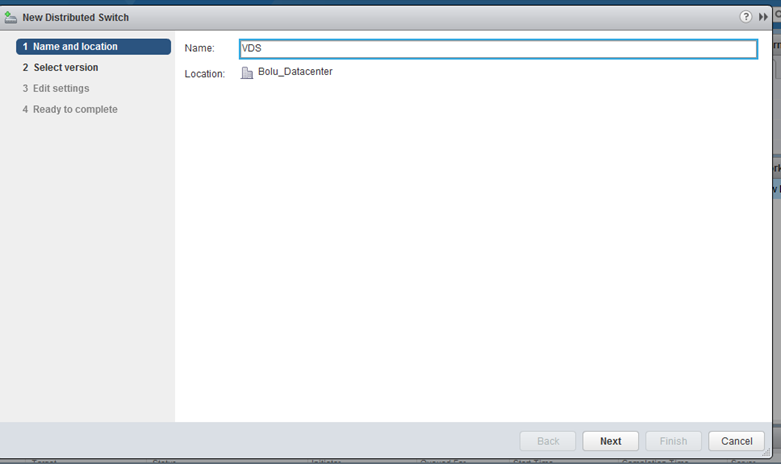

Vds için bir isim veriyorum.

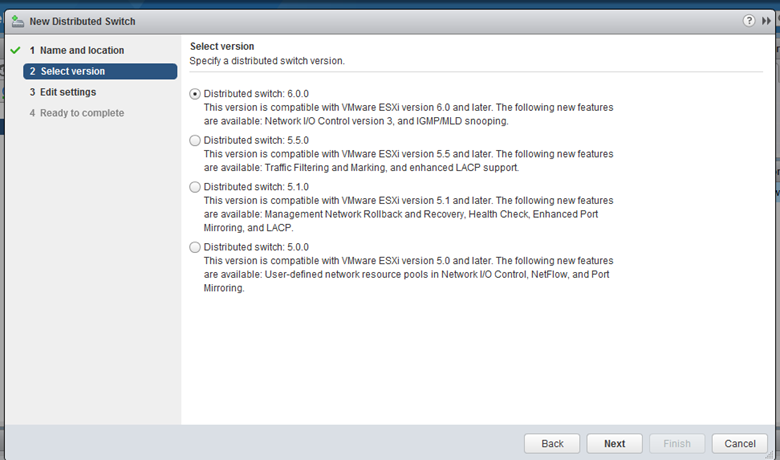

Vds versiyonunu seçiyorum , 5.1.0 versiyonundan itibaren tüm switch versiyonları lacp destekleri.Vds 6.0.0 kendinden önceki tüm özellikleri de kapsıyor.6.0 I seçip ilerliyorum.

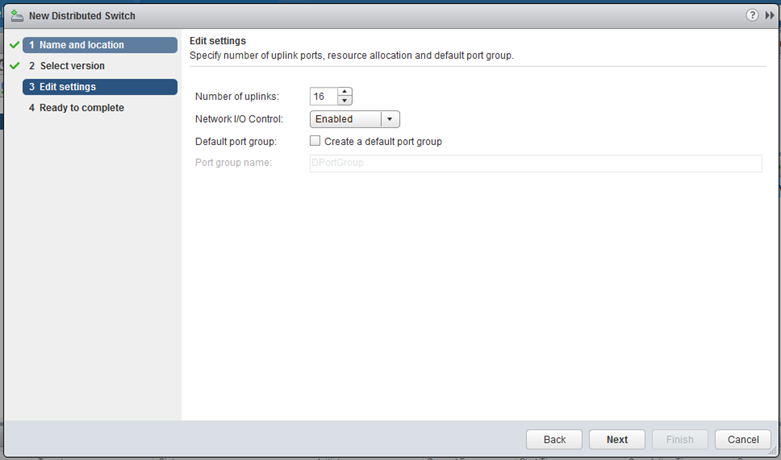

Bu kısımıda bu vds için kaç uplink bağlamak istiyorsanız ben 16 adet etherneti vds için ayıracağım bu yüzden kullanacağım uplink değeri 16 olacaktır.Daha sonra lacp konfigurasyonunda bunu göreceğiz.Network/io control aktif edilebilir.Noic sanal makina seviyesine network öncelliği ve ya bandwith policyleri oluşturabilmenize olanak sağlayan bir servistir isterseniz disable edebilirsiniz.Ben enabled şeklinde bırakıyorum devam ediyorum.

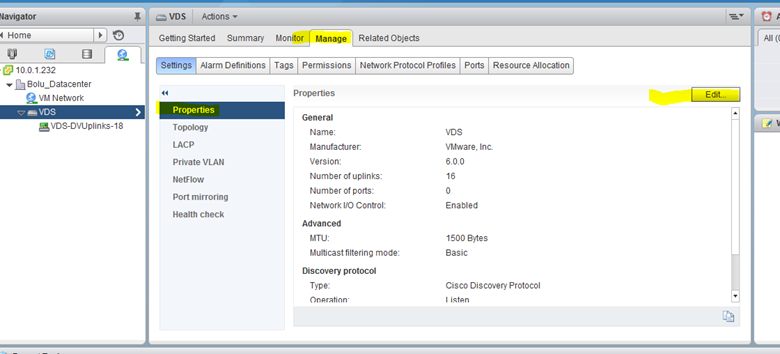

Vds oluşmuş durumda, vds üzerinde birçoğumuzun bildiği ve faydalı olduğuna inandığım bir kaç ayara göz atacağız.

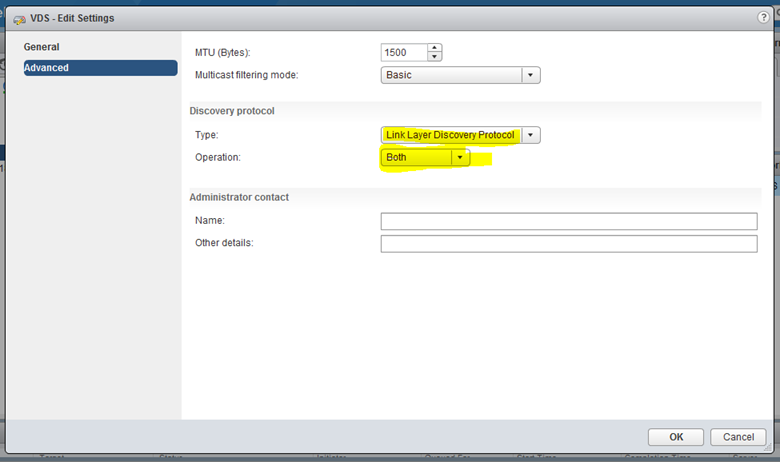

Vds I seçip manage bölümüne gelip edit diyorum.

Bu sayede vmnic’lerin fiziksel switch üzerinde hangi port üzerinde olabileceğini görebileceğiz.

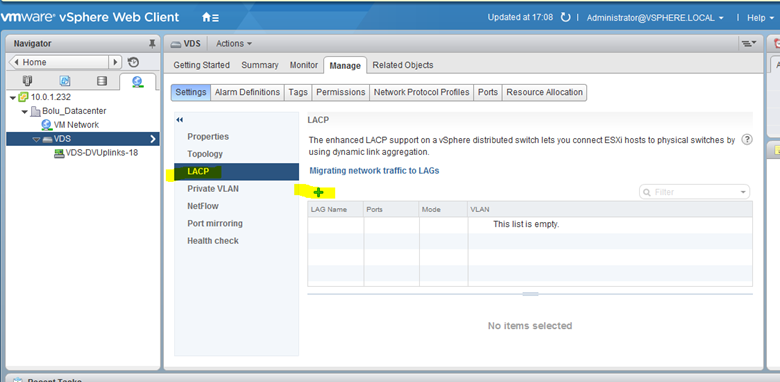

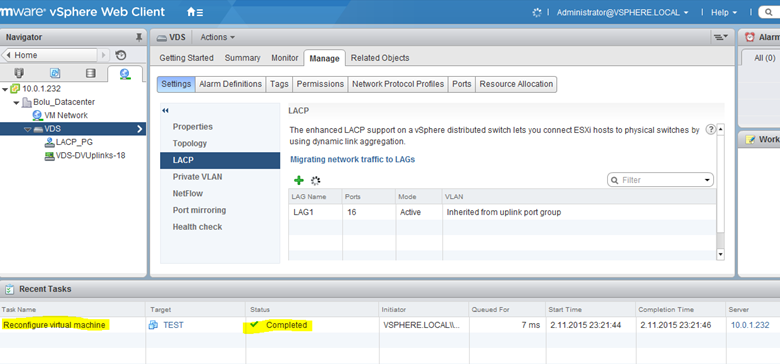

Şimdi lacp grubu oluşturmamız gerekiyor.Bunun için vds de yine lacp kısmına gelip + simgesine tıklayarak lacp’yi oluşturuyorum.

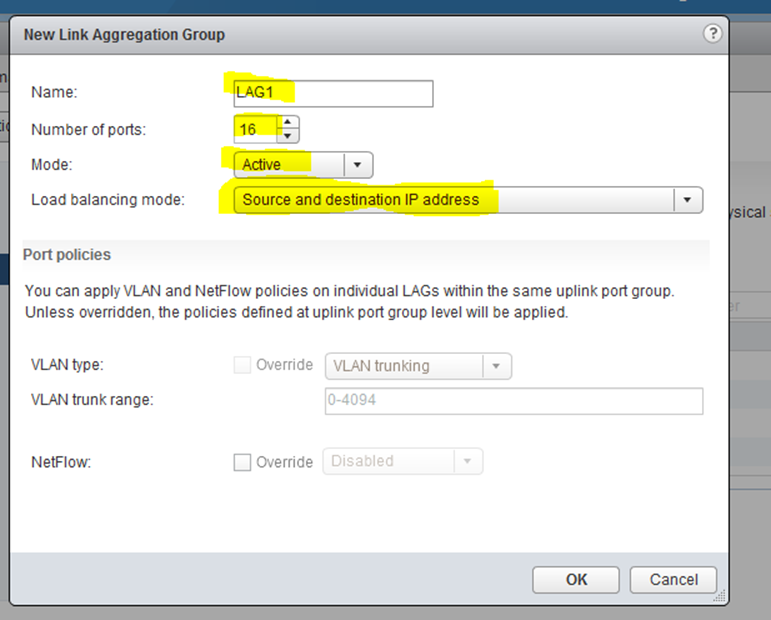

Bu kısımda kaç portu lacp’a dahil edeceksem uplink sayısı kadar port giriyorum.Mode u active ediyorum.Load balance modu olarak “source and destination ip address” seçiyorum.Algoritmam ip hash olarak olacaktır.Fiziksel switch üzerinde de lacp modunu kesinlikle “dynamic” olarak oluşturmam gerekiyor.

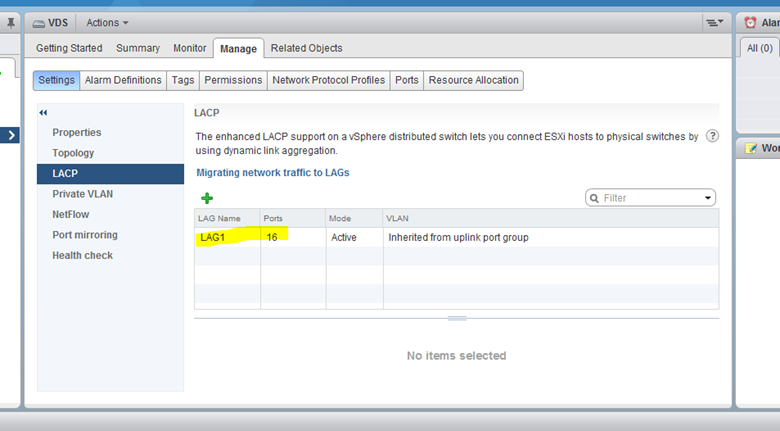

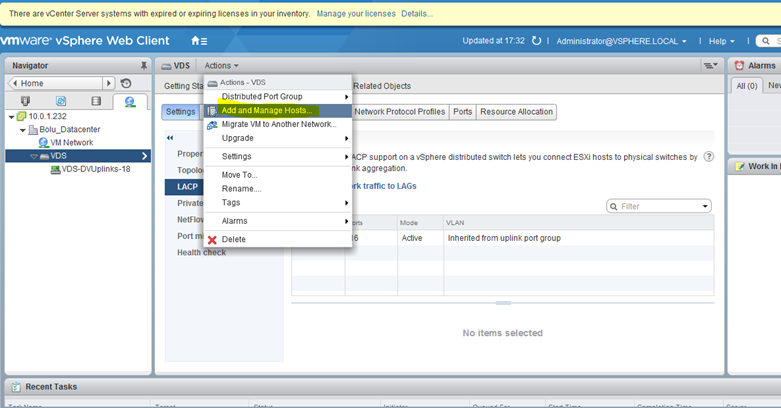

Lacp grubum oluştu şimdi lacp’ye vmnic’leri dahil edebilmek için host’ları ekliyorum.

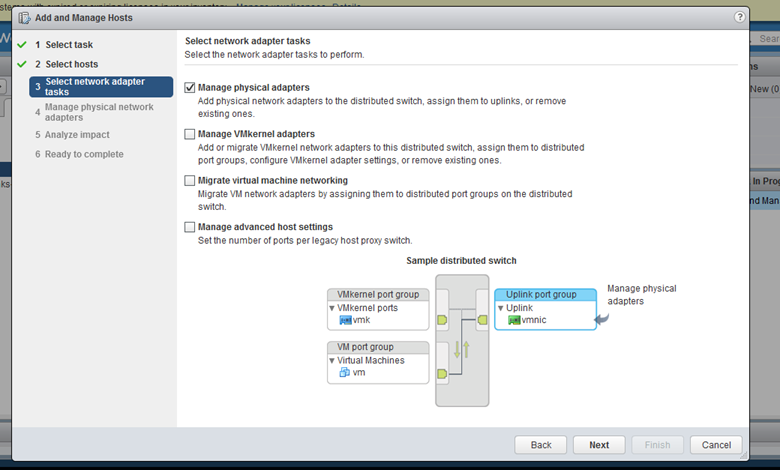

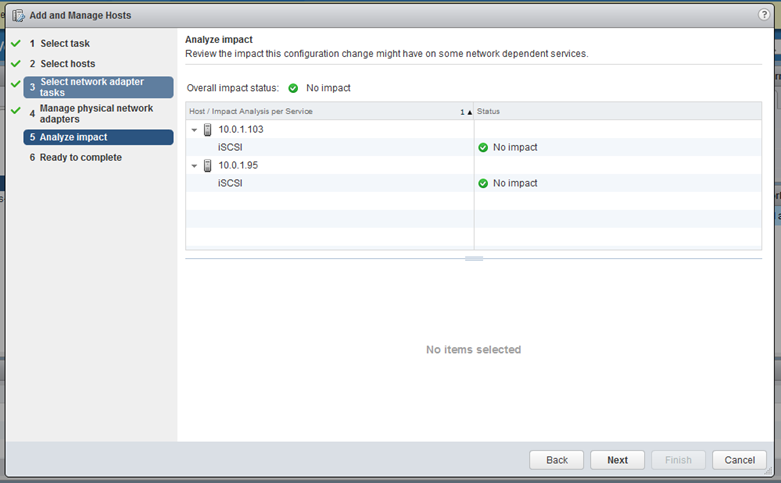

Add and Managa hosts kısmına geliyorum.

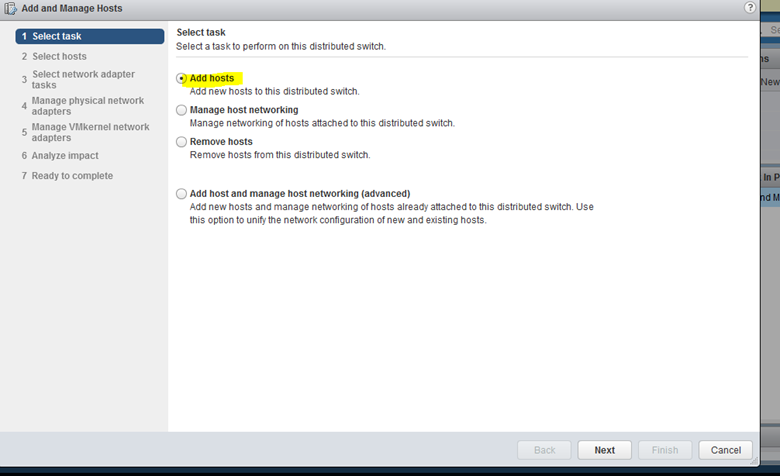

Add hosts u seçiyorum.

Sadece fiziksel ethernetleri eklemek istediğimiz manage physical adapters I seçiyorum.

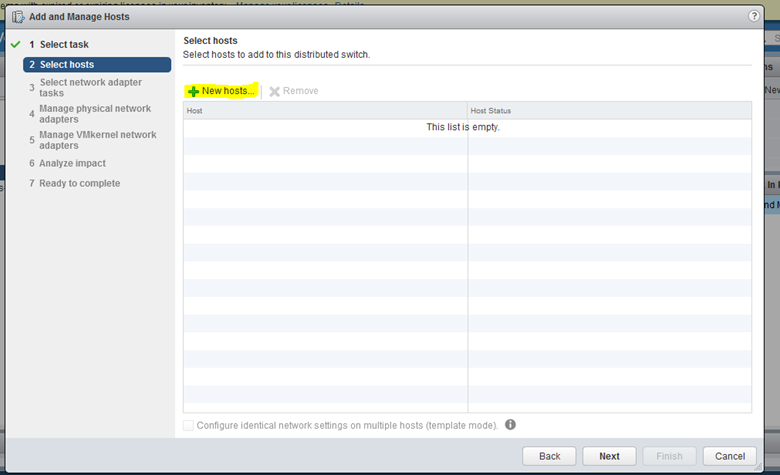

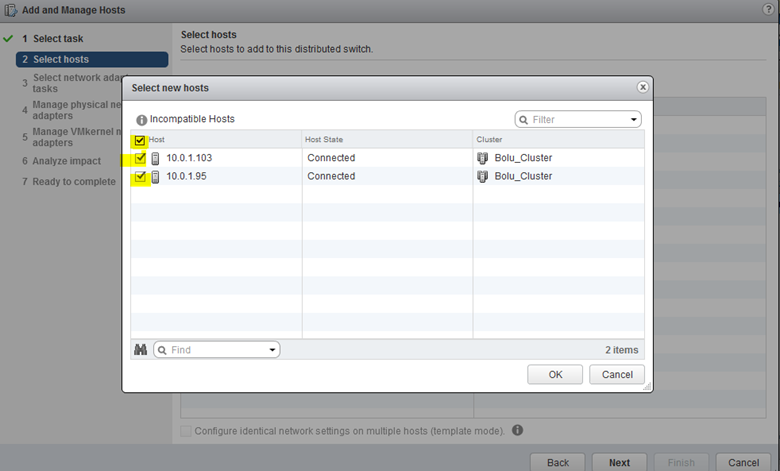

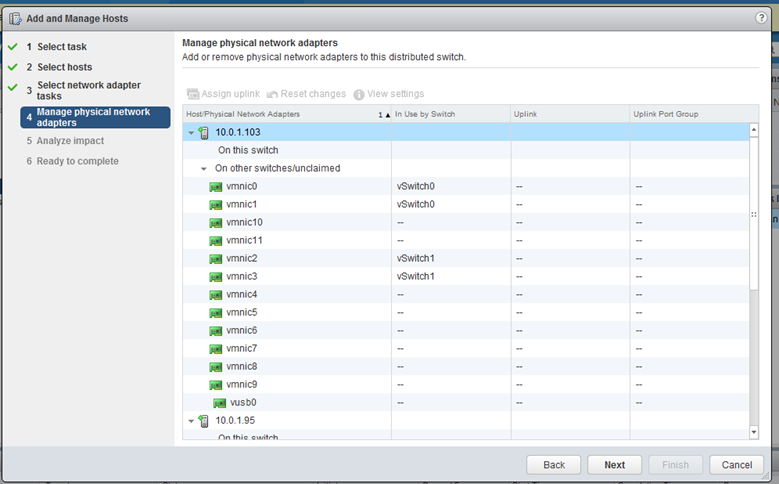

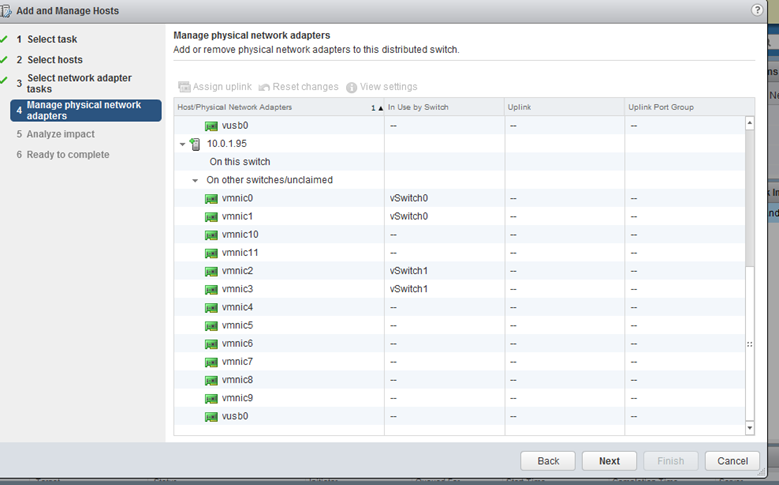

Bu kısımında fiziksel ethernetlerimizi vds atayacağız.İki sunucu üzerinde de vmnic leri görüyoruz.

Hatırlayacak olursak yukarıda hangi vmnic’leri hangi network için kullanacağımı söylemiştim.

Vmnic 0,1 à management network için

Vmnic 2-3 à vmotion vmkernel network için

Vmnic,4,5,6,7,8,9,10,11 à vDistributed switch için

Vmnic 4 den başlayarak fiziksel ethernet’leri atama işlemine başlıyorum.

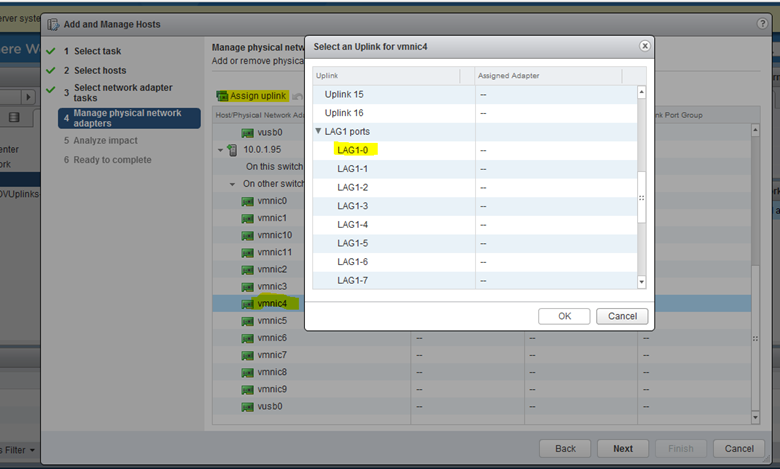

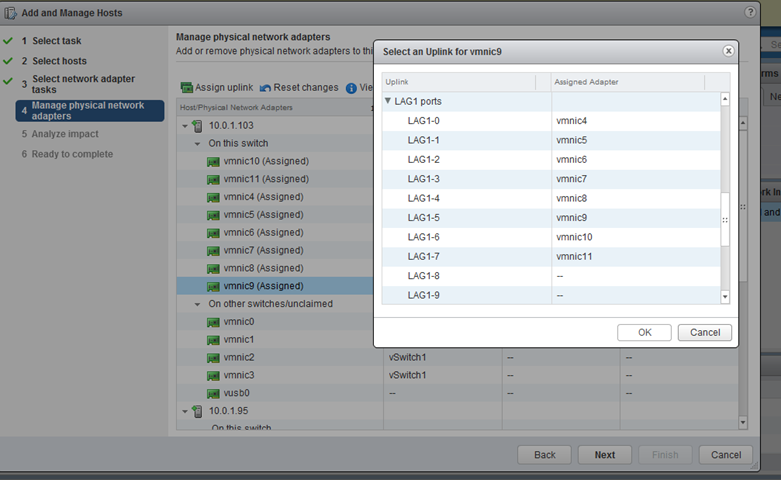

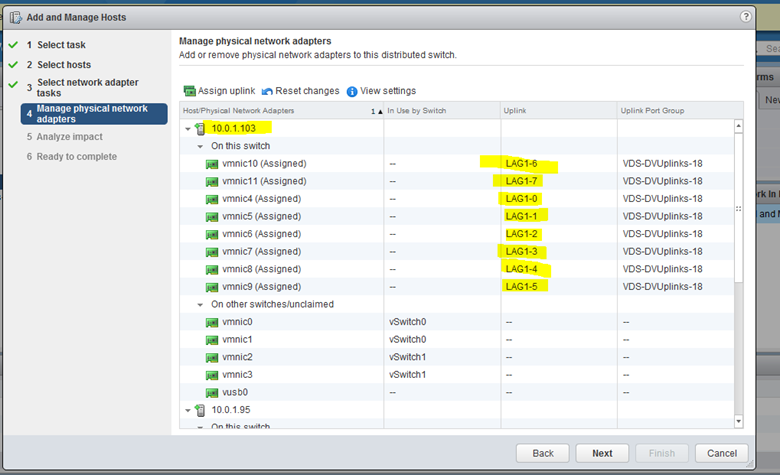

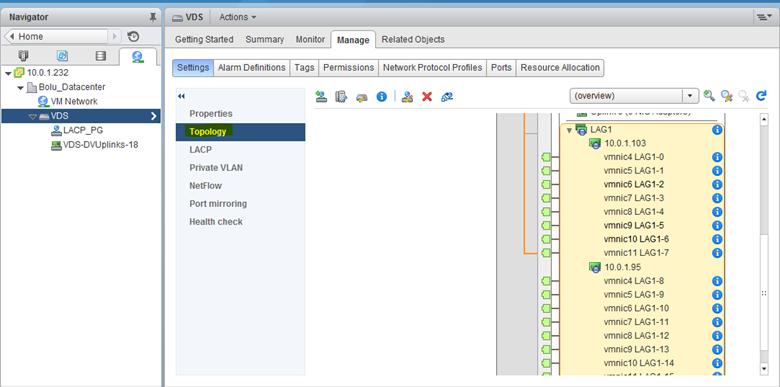

Vmnic 4 seçip Assaign uplink’e tıklıyorum , vds üzerinde oluşturduğum lacp group u seçerek 0 dan başlayarak devam ediyorum.

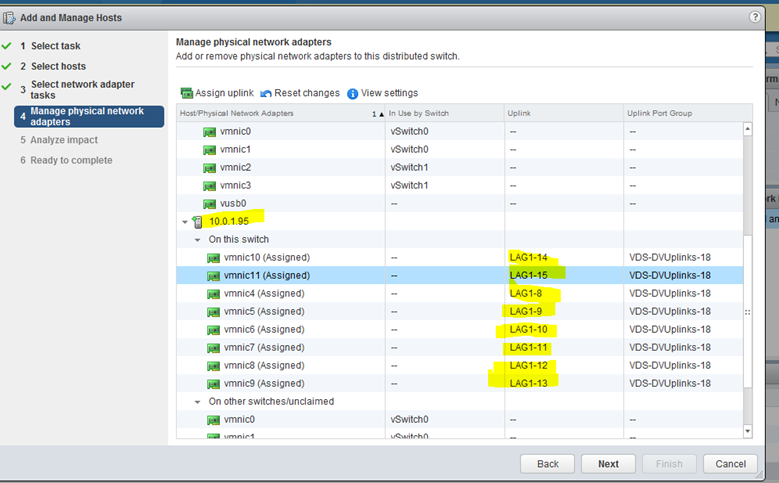

Her iki sunucuda lacp için kullanabileceğim port sayım 8 adet , lag grubu için 0-7 ye kadar portlara kartları atadım , 8-15 arası lag portlarına da ikinici sunucumdaki vmnic yani fiziksel kartları atıyorum.

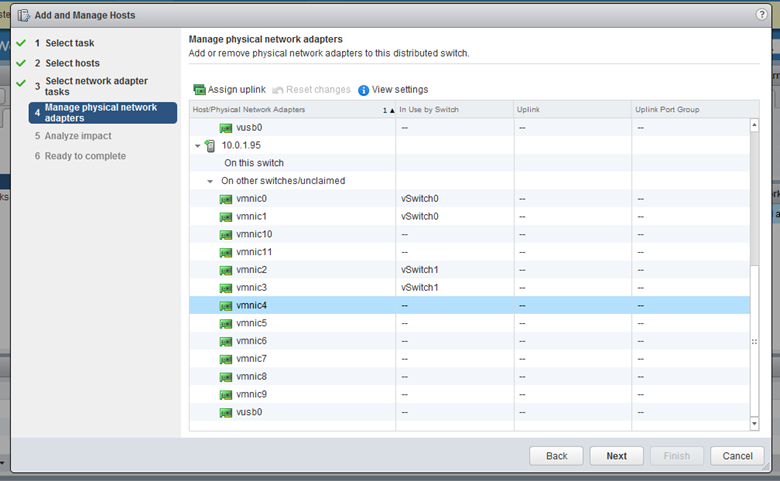

Bu yüzden ikinci sunucuya gelip vmnic 4 den başlayarak geri lag portlarına atamaları yapıyorum.

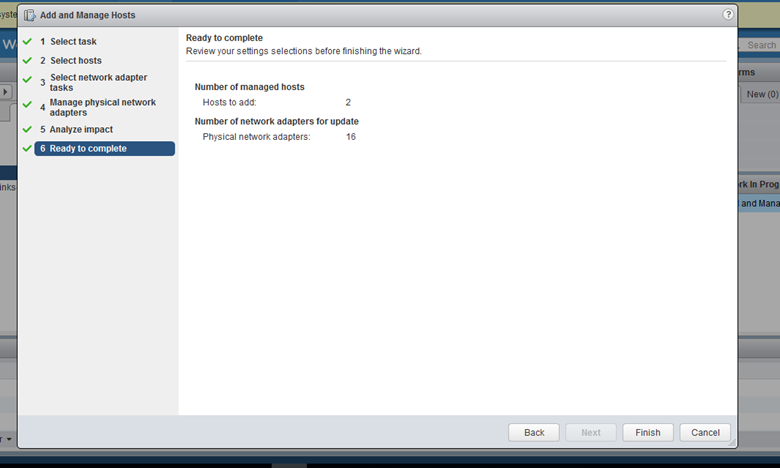

İki sunucuda 8 er adet portu lag portlarına atayıp atama işlemlerini gerçekleştirdik.

Vds üzerinde 2 sunucumuzu ve 16 fiziksel ağ kartımızı lacp ye atamasını gerçekleştirdik.

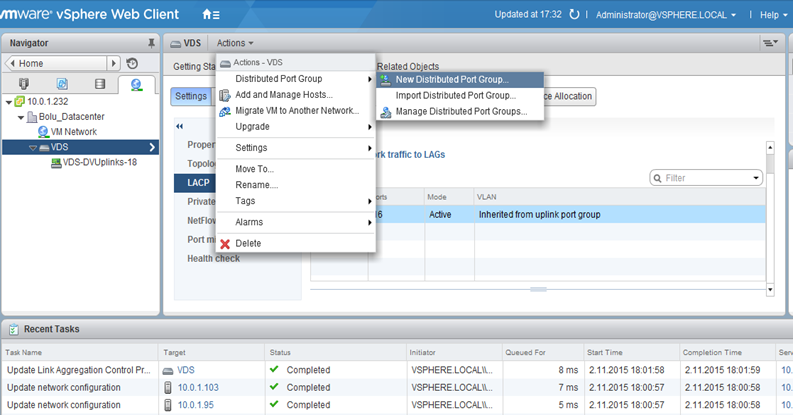

Sanal makinaların bu network ile görüşebilmesi bir port group tanımlaması yapmamız gerekecek.Bu port group üzerindeki aksiyonlar , iletişim methodları oluşturcağımız sanal network üzerinden gerçekleşecektir.

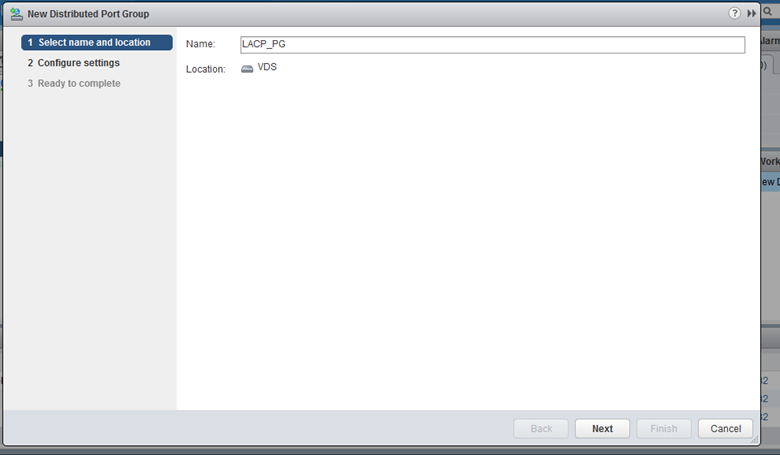

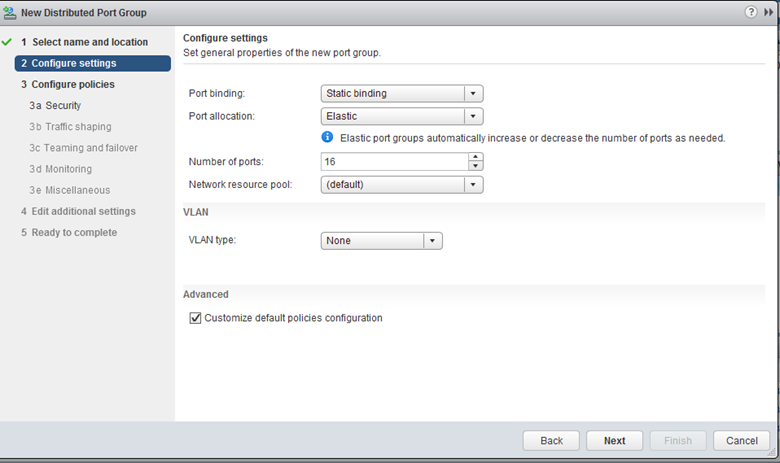

Burada teaming and failover seçeneğinin aktif olabilmesi customize kutusunu işaretliyorum.Kullanacağım port sayısınıda 16 adet olduğu için 16 ya çıkarıyorum.

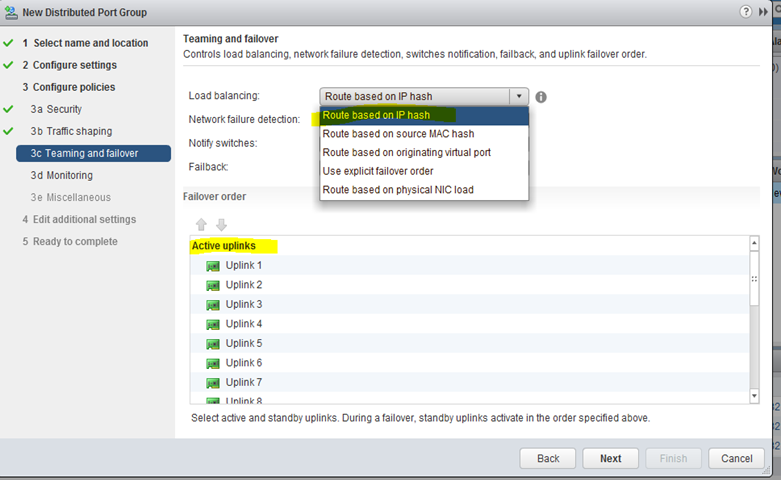

Teaming and failover kısmında ip hash algoritmasını kullanacağımız için esxi’in önceki versiyonlarında olduğu gibi “route based ip hash” I seçiyorum.

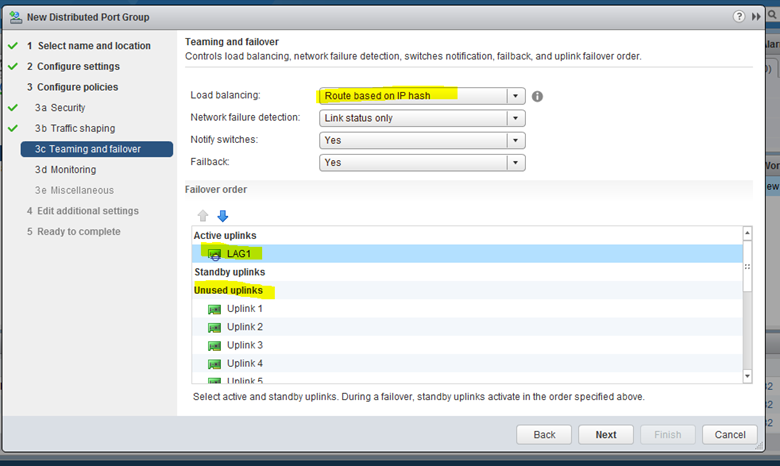

Active uplinks kısmında oluşturmuş olduğumuz lag grubunu active uplink’lere alıp geri kalan uplinkleri unused konumuna getiriyorum.

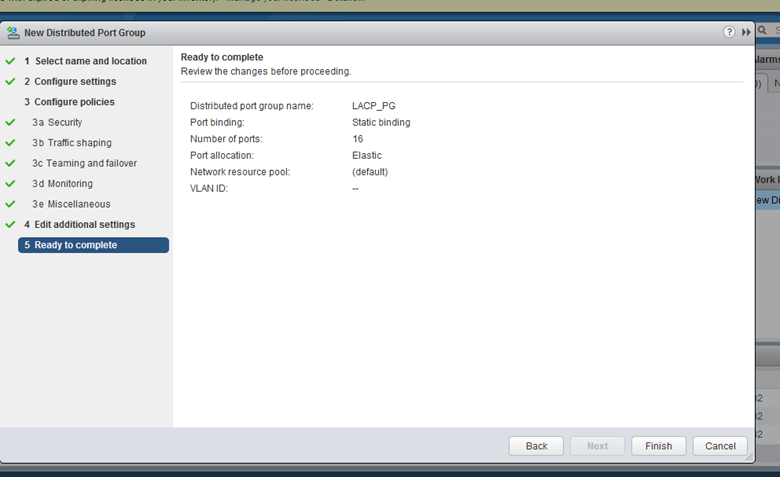

Finish diyerek sanal makinalarımızın kullanacağı pg oluşturma işlemini tamamlıyoruz.

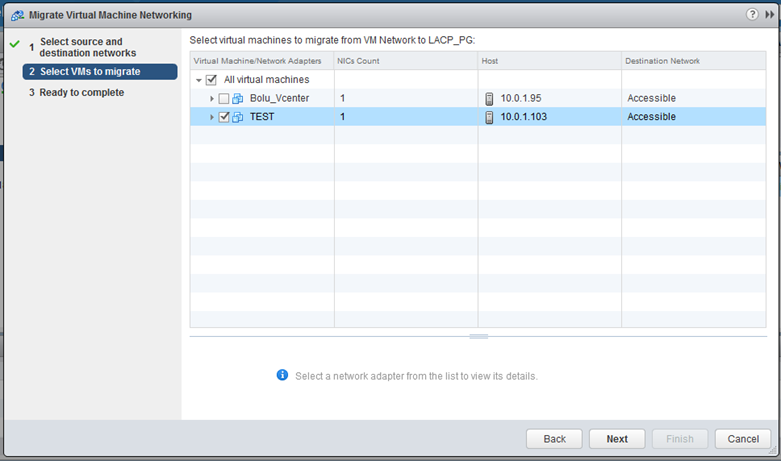

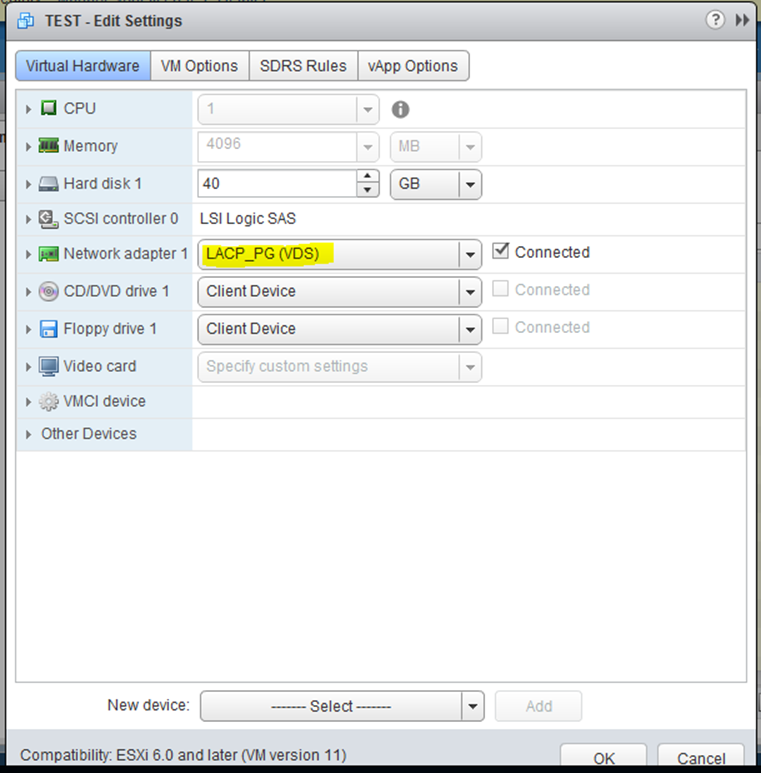

Şimdi sanal makinalarımızı oluşturmuş olduğumuz network’e taşıyalım.

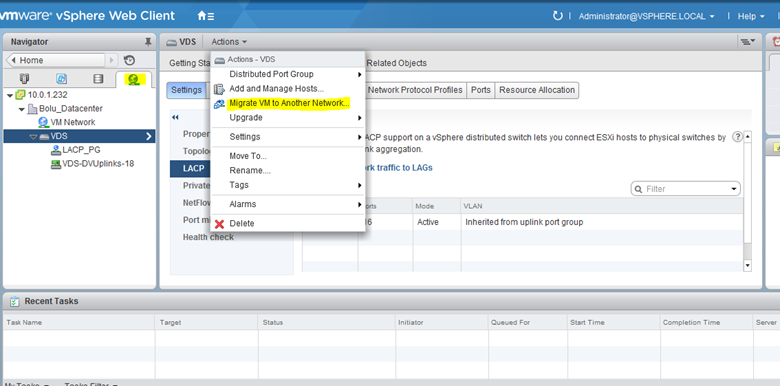

Networking tabı’na gelip “migrate Vm to Another Network e tıklıyorum.

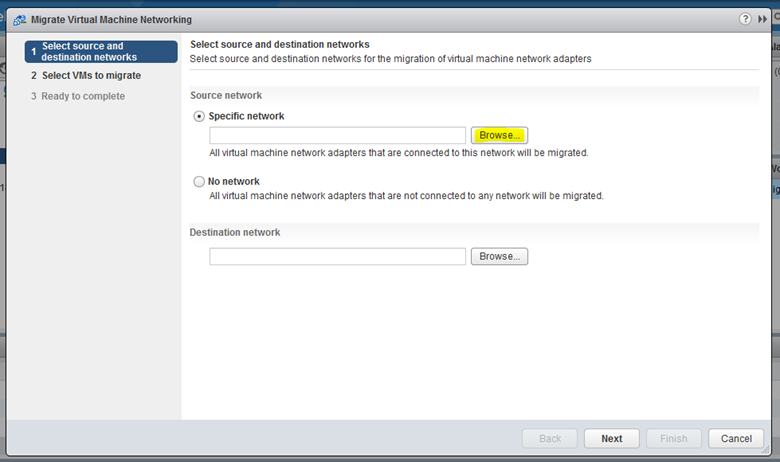

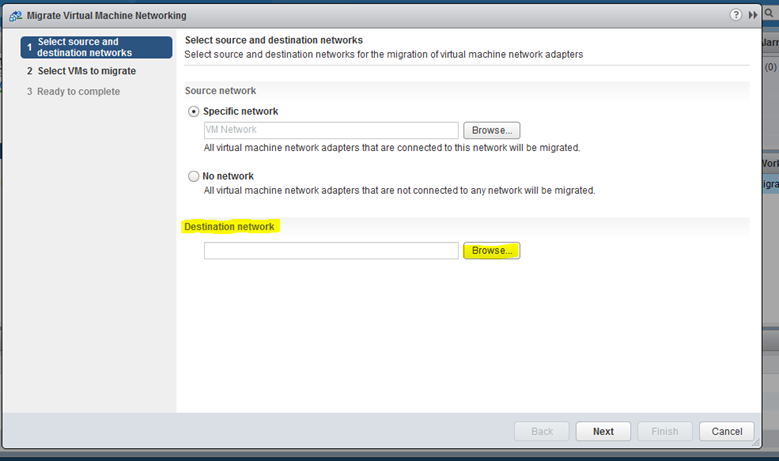

Bu kısımda sanal makinamızın bağlı olduğu network’ü seçiyoruz.

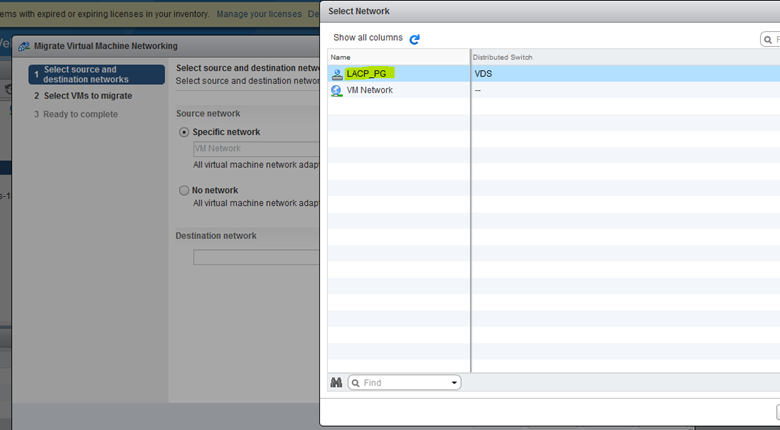

Destination olarak oluşturmuş olduğumuz port groupu Lacp_Pg yi seçiyorum.

Bu kısımda bu networke taşıyacağımız sanal makinalarımızı seçiyoruz.

Taşıma işlemi tamamlandı.

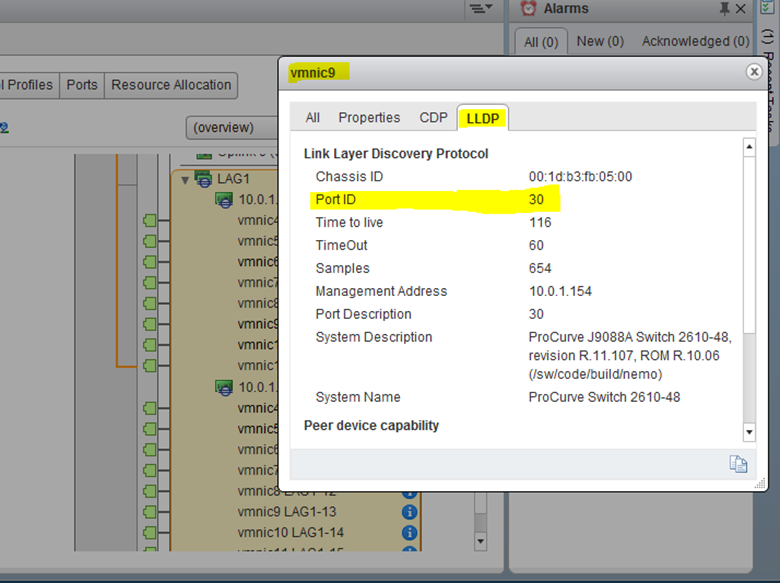

Şimdi asıl önemli olay, switch tarafındaki konfigurasyon da, vmnic’lerin bağlı olduğu portları lldp sayesinde görebileceğiz.

Lag grubuna üye yaptığımız uplink’ler fiziksel ağ kartlarımız sağ tarafta görünüyor.İnformation simgesine bakarak vmnic’in hangi porta bağlı olduğunu control edelim.

Vmnic 9 , procurve switch üzerinde 30.portta ve switch’in bağlı olduğu management ip adresi de 10.0.1.154 olarak görünüyor.

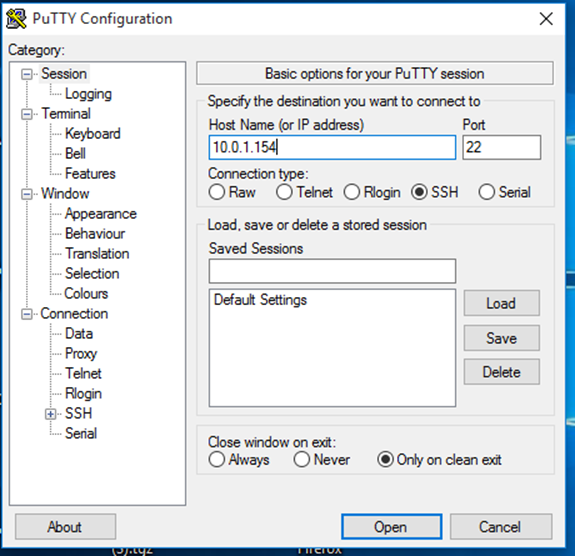

Putty ile switch’e bağlanıyorum.Ssh tanımlarını yaptıysanız ssh üzerinden bağlanabilirsiniz.ip üzerinden ssh ile bağlanmak istiyorsanız

Switch01# crypto key generate ssh

Switch01# ip ssh

Switch01# crypto key generate cert 1024

Switch01# web-management ssl

Switch01# no web-management plaintext

Switch01# no telnet-server

Komutları ile sadece ssh üzerinden erişebilecek şekilde configure edebilirsiniz.

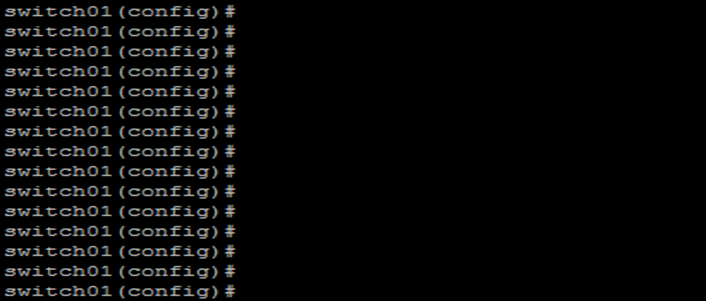

Config t ile config dizinine düşüp lacp yapmak istediğim portları yazıyorum.Bunun için bana gerekli olan komut

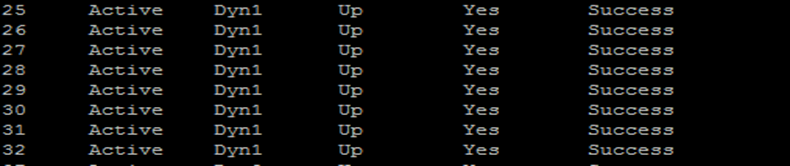

Esxinode1 üzerinde 8 port için modu “dynamic” olacak şekilde port grubu oluşturuyorum.

switch01(config)# interface ethernet 25,26,27,28,29,30,31,32 lacp active

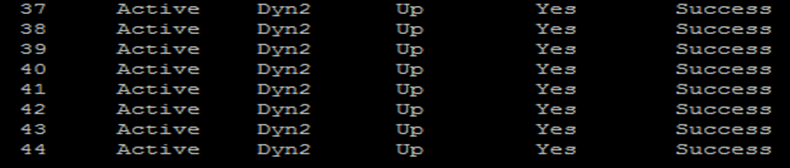

Şimdi de Esxinode2 üzerinde 8 port için modu “dynamic” olacak şekilde port grubu oluşturuyorum.

switch02(config)# interface ethernet 37,38.39,40,41,42,43,44 lacp active

Bunu bu şekilde yapmamın sebebine gelince;

Esxi host 1 üzerinde 8 adet port’um var VDS üzerinde lacp_pg grubuna bağlı

Esxi host 2 üzerinde 8 adet port2um var VDS üzerinde lacp_pg grubuna bağlı

Ve iki adet fiziksel switch üzerinde bu port’ları 16 portu 2’şer dynamic gruba ayırarak gruplandırdım.

Vcenter üzerinde oluşturmuş olduğum lacp_pg distribution port grubunda toplam da 16 adet uplink var. yani şuan da sanal makina hangi node üzerinde olursa olsun lacp_pg networküne bağlı olan networkü kullanıyor.

Switch’ler stack durumda değil , birbirinden iki bağımsız switch olduğu için node’lardan biri down olduğu durumda lag grubu içerisinde tanımlı olan aktif portları hala kullanmaya devam edecek.Fakat bu durumda toplam kullanacağı aktif port sayısı doğal olarak 8’e düşecek.En başında zaten benim oluşturmak istediğim 8 + 8 her durumda çalışabilir olmasıydı , switch’leride donanımsal bir problem oluşmasına karşı ayırdığım için her iki switch üzerinde iki farklı lacp grubu oluşturup vds de bu portları mantıksal olarak birleştirdim.Distributed switch’I iki node a atadığım için iki node üzerinde erişebilir konumda olacak ve yine her iki switch üzerindeki tanımlı olan lacp port gruplarına erişebilir olacak.

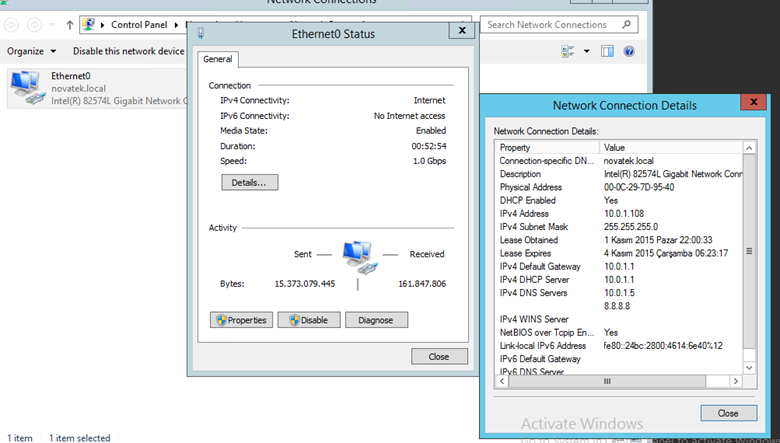

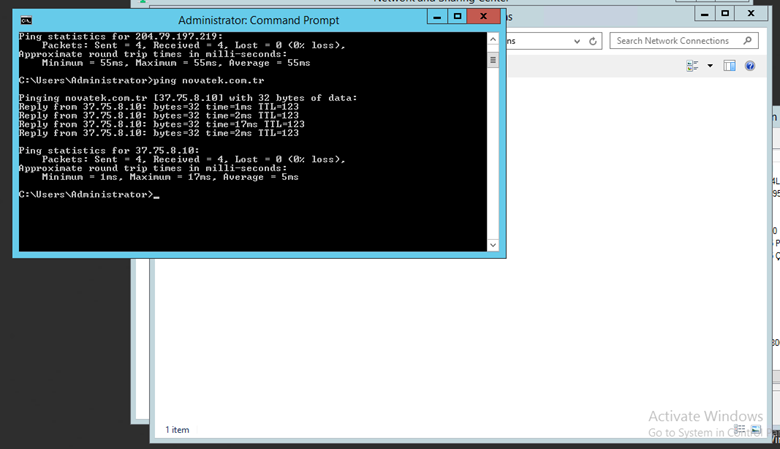

En son sanal makinamızı vmnetwork’den lacp_pg ye taşımıştık.

Network migration sonrası vm de herhangi bir sıkıntı görünmüyor.Cluster’a uygun bir şekilde sanallaştırmayı tamamlamış olduk.Faydalı olmasını dilerim.